Nowinki i ciekawostki naukowe Archiwum nowinek naukowych

Różności

Bakterie pomocne w renowacji dzieł sztuki (10-06-2011) | U większości osób słowo bakterie przywołuje wizję albo paskudnych mikroorganizmów, z którymi musimy zmagać się na co dzień, czyszcząc otaczające nas przestrzenie, albo dobrych bakterii, których spożycie zalecają lekarze, by utrzymać nasz układ trawienny w dobrej kondycji.

Ale kto by przypuszczał, że bakterie można zatrudnić do renowacji dzieł sztuki?

Otóż zespołowi ekspertów z Hiszpanii i Włoch, zajmujących się renowacją dzieł sztuki, udało się wykazać, że można oczyszczać arcydzieła za pomocą bakterii w sposób szybki, ukierunkowany i ostrożny. Na dodatek pokazali również, że prócz poszanowania dla malowideł, te użyteczne mikroorganizmy są łagodne dla samych konserwatorów i otaczającego środowiska. Dostępne do tej pory opcje polegały na renowacji za pomocą żrących, nieselektywnych i toksycznych substancji chemicznych albo erozji twardej powłoki przy wykorzystaniu często szkodliwych sposobów mechanicznych.

Dzięki współpracy Instytutu Renowacji Dziedzictwa Kulturowego (IRP) przy Uniwersytecie w Walencji, Hiszpania, z ekspertami pracującymi nad renowacją malowideł ściennych Campo Santo di Pisa, Włochy, wypróbowano i przetestowano nowe metody.

Współpraca została nawiązana przy okazji pracy konserwatorów z IRP nad malowidłami ściennymi w kościele Santos Juanes w Walencji, Hiszpania. Tamtejsze malowidła ścienne były niemal całkowicie zniszczone w następstwie pożaru w 1936 r., a potem padły ofiarą nieudolnej renowacji w latach 60. XX w. Zespół z IRP rozpoczął eksperymentowanie z nowymi technikami "wypełniania" za pomocą przenoszonych drukowanych obrazów cyfrowych miejsc, w których odpadła farba. Jednak wykwity soli - białe pęcherzyki pojawiające się na malowidłach z powodu nawarstwiania się skrystalizowanej soli i kleju żelatynowego - okazały się poważną przeszkodą.

"W następstwie oddziaływania grawitacji i parowania, sole z ulegającej rozkładowi materii organicznej migrują do malowideł i wytwarzają białą skorupę przysłaniającą dzieło sztuki, a czasami mogą powodować również poluzowanie warstw farby" - zauważa dr Pilar Bosch, jedna z konserwatorek z IRP.

Aby zbadać inne opcje, naukowcy z IRP wybrali się do Włoch w celu zasięgnięcia informacji o pionierskich pracach prowadzonych w Campo Santo di Pisa.

Pod kierunkiem mikrobiologa Gainluiggi Colalucciego konserwatorzy wykorzystali tam bakterie do usuwania stwardniałego kleju, który tradycyjnym metodom sprawia tyle trudności.

Wykorzystywane bakterie to szczep Pseudomanas, który dosłownie zjada wykwity soli gromadzące się w sklepieniach łukowych, na których znajdują się malowidła i gdzie zazwyczaj lubią przebywać gołębie.

Dzięki współpracy dwóch krajów konserwatorzy mogli wymienić się najlepszymi praktykami i dowiedzieć się, co się najlepiej sprawdza na różnych typach malowideł.

"We Włoszech mikroorganizmy są nanoszone za pomocą waty" - zauważa dr Bosch. "Natomiast my opracowaliśmy żel, który działa na powierzchni i zapobiega przedostawaniu się wilgoci głęboko do materiału i powodowaniu nowych problemów."

Jako że bakterie rozwijają się dobrze jedynie w wilgotnych środowiskach, dr Bosch wyjaśnia wagę procesu suszenia: "Po upływie półtorej godziny usuwamy żel razem z bakteriami. Powierzchnia jest wówczas czyszczona i suszona."

Największa arcydzieła europejskie zawsze były kruche. Oddzielające nas od naszych ulubionych dzieł barierki ze sznurów i gabloty muzealne stanowią dowód ich delikatnej natury. Niemniej teraz, dzięki ostatnim badaniom, wiekowe arcydzieła mogą być utrzymywane w "młodości" przez wiele nadchodzących lat.

"Po uzyskaniu dobrych wyników testów będziemy kontynuować prace badawcze i doskonalić technikę w celu przeniesienia jej na inne powierzchnie" - zauważa dr Bosch. "Ponieważ w naturze odnajdujemy przeróżne gatunki bakterii żywiące się niemal wszystkim, jesteśmy przekonani, że możemy usunąć inne substancje z różnych typów materiałów."

© Unia Europejska 2005-2011

Źródło: CORDIS | | |

Fizyka

Fizyka kwantowa schładzania superkomputerów (08-06-2011) | Czy zastanawialiście się kiedyś nad fizyką stojącą za charakterystycznym szumem laptopa, kiedy się przegrzewa leżąc na kolanach? Albo nad wszechogarniającym ciepłem generowanym przez pomieszczenia biurowe wypełnione włączonymi komputerami lub serwerownie?

Międzynarodowy zespół fizyków teoretycznych dokonał ostatnio wyjątkowego odkrycia, że komputery mogą równie dobrze generować ciepło, jak i chłód.

W artykule opublikowanym w czasopiśmie Nature zespół z Wlk. Brytanii, Szwajcarii i Singapuru wyszedł od powszechnie uznanego faktu, że energia zużyta przez włączone komputery ostatecznie przekształci się w ciepło. Badania, które otrzymały wsparcie finansowe od Europejskiej Rady ds. Badań Naukowych ujawniają, że w pewnych warunkach usuwanie danych może wytworzyć efekt chłodzenia.

Odkrycia te mogą mieć znaczenie w kontekście możliwości ręcznego schładzania tak zwanych "superkomputerów", których wydajność jest często ograniczona z powodu ich przegrzewania się. Superkomputery są wykorzystywane do zadań wymagających ogromnych zdolności przetwarzania, na przykład w meteorologii czy modelowaniu molekularnym.

Naukowcy wyjaśniają, że efekt schładzania jest następstwem zjawiska kwantowego splątania. "Uzyskanie takiej kontroli na poziomie kwantowym, jaka potrzebna byłaby do wdrożenia tego w superkomputerach stanowi wprawdzie potężne wyzwanie technologiczne, ale nie musi to być niemożliwe. W ciągu ostatnich 20 lat poczyniono znaczące postępy w technologiach kwantowych" - wyjaśnia Vlatko Vedral, współautor artykułu. "Dzięki technologii dostępnej obecnie w laboratoriach fizyki kwantowej powinno być możliwe przeprowadzenie doświadczenia prognostycznego na kilku bitach danych."

To fizyk Rolf Landauer jako pierwszy odkrył w 1961 r., że usuwanie danych powoduje w sposób nieuchronny uwolnienie energii pod postacią ciepła. Ta zasada oznacza, że po przekroczeniu pewnej liczby operacji arytmetycznych na sekundę komputer wygeneruje ciepło w ilościach niemożliwych do rozproszenia. Chociaż w przypadku dzisiejszych superkomputerów istotniejsze są inne źródła ciepła, zespół jest przekonany, że krytyczny próg, przy którym ciepło generowane przez wymazywanie - zgodnie z zasadą Landauera - stanie się istotne może zostać osiągnięty w ciągu kolejnych od 10 do 20 lat.

Ciepło powstające przy wymazywaniu dysku twardego o pojemności 10 terabajtów wynosi niewiele ponad jedną milionową dżula. Aczkolwiek, jeżeli proces wymazywania zostałby powtórzony wielokrotnie w ciągu sekundy, wówczas nastąpi odpowiednia akumulacja ciepła.

Nowe badania stawiają ponownie w centrum uwagi zasadę Landauera w przypadkach, w których wartość bitów do wymazania może być znana. Kiedy znana jest zawartość pamięci, powinno być możliwe wymazanie ich w taki sposób, który teoretycznie umożliwia odtworzenie ich.

W toku wcześniejszych badań wykazano, że takie odwracalne wymazanie nie wygeneruje ciepła. Postęp poczyniony w ramach nowych badań polega na wykazaniu, że kiedy bity do wymazania są kwantowo-mechanicznie splątane ze stanem obserwatora, wówczas może on nawet wyciągnąć ciepło z systemu w czasie wymazywania bitów. Splątanie wiąże stan obserwatora ze stanem komputera w taki sposób, że wie on więcej o pamięci niż jest to możliwe w fizyce klasycznej.

W ramach badań zespół wykorzystał pojęcia z teorii informacji i termodynamiki w koncepcji zwanej entropią. W teorii informacji entropia jest pomiarem gęstości informacji, który opisuje ile pojemności pamięci zajmie dany zbiór danych przy optymalnej kompresji. Natomiast w termodynamice entropia odnosi się do nieuporządkowania w systemach, na przykład do układu molekuł w gazie. W termodynamice zwiększenie entropii systemu zwykle jest równoważne z dodaniem energii, takiej jak ciepło.

"Wykazaliśmy teraz, że w obydwu przypadkach termin entropia tak naprawdę opisuje tą samą rzecz, nawet w reżimie kwantowo-mechanicznym. Wyniki naszych badań wskazują, że w obydwu przypadkach entropia jest uznawana za swego rodzaju brak wiedzy" - mówi Renato Renner z zespołu badawczego.

W praktyce odkrycia te oznaczają, że jeżeli dwie osoby wymażą dane z pamięci, a jedna ma większą wiedzę na ich temat, pamięć jest postrzegana jako cechująca się niższą entropią i może zostać wymazana przy użyciu mniejszej energii.

Badania, prócz swojej przydatności dla naszej wiedzy o wytwarzaniu ciepła przez komputery, mogą mieć pozytywny wpływ na rozwój innowacyjności w termodynamice.

© Unia Europejska 2005-2011

Źródło: CORDIS

Referencje dokumentu: Del Rio, L., et al. (2011) The thermodynamic meaning of negative entropy. Nature. DOI: 10.1038/nature10123. | | |

Różności

Nowa metoda rozmotywania nici jedwabnej (05-06-2011) | Naukowcy z Uniwersytetu Oksfordzkiego w Wlk. Brytanii odkryli, że powierzchnia kokonów dzikich jedwabników pokryta jest mineralną warstwą szczawianu wapnia, co komplikuje proces rozmotywania. Usunięcie tej warstwy ułatwia rozwijanie kokonów na długie nitki jedwabiu podobne do tych, jakie pozyskuje się z udomowionego jedwabnika morwowego (Bombyx mori, B. mori). Badania zostały częściowo dofinansowane z projektu SABIP (Jedwabie jako biomimetyczne ideały dla polimerów), który otrzymał grant Europejskiej Rady ds. Badań Naukowych (ERBN) o wartości niemal 2,3 mln EUR z budżetu Siódmego Programu Ramowego (7PR) UE. Odkrycia zaprezentowane w czasopiśmie Biomacromolecules mogą pomóc w rozwinięciu się nowego przemysłu jedwabniczego w Azji, Afryce i Ameryce Południowej, bowiem w tych regionach dzikich jedwabników jest pod dostatkiem.

Ludzie już dawno temu dostrzegli kluczową dla przemysłu jedwabniczego rolę motyli jedwabników. Tkaniny jedwabne po raz pierwszy pojawiły się w starożytnych Chinach już w roku 3500 p.n.e. Produkowano je rozplątując cienką, delikatną nitkę z kokonów motyla jedwabnika, ale większość jedwabiu, jaki znajduje się obecnie na rynkach pochodzi z kokonów B. mori. Rozmotywanie (rozwijanie) nitki tego jedwabnika jest proste i umożliwia pozyskiwanie długich, ciągłych nici.

Dla specjalistów z przemysłu jedwabniczego rozmotywanie nici kokonów "dzikich" gatunków nie jest łatwym zadaniem. Aby pozyskać żądany produkt pracownicy poddają kokony surowszym metodom. Minusem jest jednak następujące zazwyczaj uszkodzenie nici, co przekłada się na gorszej jakości jedwab. I tutaj do akcji wkracza zespół z Oksfordu, któremu udało się opracować i przetestować metodę rozmotywania nici jedwabnych z naturalnych kokonów bez uszkadzania ich.

Naukowcy przetestowali swoją metodę na dzikim jedwabniku Gonometa postica. Wykorzystując ciepły roztwór kwasu etylenodiaminotetraoctowego (EDTA), zespół zmiękczył kokony na tyle, że rozmotywanie wyhodowanego jedwabiu bez uszkodzenia nici przebiegało bezproblemowo.

Dzięki "zdemineralizowaniu" powierzchni kokonów - tj. usunięciu mineralnej warstwy szczawianu wapnia - naukowcy byli w stanie rozmotać kokony w długie i ciągłe nici za pomocą przemysłowych maszyn rozmotalniczych. Pozyskane nitki mogą z łatwością rywalizować z nićmi z kokonów jedwabnika morwowego.

"W odróżnieniu od tradycyjnych sposobów obróbki kokonów dzikich jedwabników - takich jak odgumowywanie za pomocą soku ananasowego, zgrzeblenie i ręczne przędzenie - nasza nowa metoda zmiękcza kokony, aby umożliwić rozmotywanie bez uszkadzania nici, co zapewnia jedwabiowi pożądane właściwości" - wyjaśnia Tom Gheysens z Wydziału Zoologii Uniwersytetu Oksfordzkiego, który kierował pracami wraz z profesorem Fritzem Vollrathem, opiekunem projektu z ramienia Uniwersytetu. "Proces demineralizacji umożliwia, po raz pierwszy, pozyskanie długiej i ciągłej nici jedwabnej z dzikich kokonów produkujących wysokiej jakości dziki jedwab, który jest potencjalnie godnym rywalem odmiany hodowlanej."

W podsumowaniu artykułu czytamy: "Włókna G. postica, których wcześniej nie badano zbyt szczegółowo, pozyskiwane w ten sposób wykazały konkurencyjne właściwości w stosunku do włókien produkowanych przez komercyjnego jedwabnika morwowego B. mori. To sugeruje, że nasza metoda odgumowywania powinna poszerzyć zakres gatunków jedwabnika morwowego, które można rozmotywać na mokro i które mogą stać się istotne dla rozwoju przemysłu jedwabniczego nie tylko w Azji, ale również w Afryce i Ameryce Południowej."

Wkład w badania wnieśli naukowcy z Uniwersytetu w Bristolu, Commercial Insects Program i Międzynarodowego Centrum Fizjologii i Ekologii Owadów w Kenii.

© Unia Europejska 2005-2011

Źródło: CORDIS

Referencje dokumentu: Gheysens, T., et al. (2011) Demineralization enables reeling of Wild Silkmoth cocoons. Biomacromolecules. DOI: 10.1021/bm2003362. | | |

Biologia

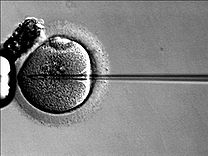

Plemnik plemnikowi nierówny (05-06-2011) | Nasienie ludzkie - mimo swej pozornej homogeniczności - może wykazywać bardzo dużą zmienność nawet w obrębie pojedynczej próbki. Co więcej - wbrew obiegowym opiniom - zawiera jedynie stosunkowo niewielką populację plemników rzeczywiście zdolnych do zapłodnienia komórki jajowej. Hipotezy próbujące wyjaśnić przyczyny takiej rozrzutności męskiego układu rozrodczego są liczne - uważa się na przykład, że część "nadmiarowych" gamet służy li i jedynie zajęciu zajęciu żeńskich sił obronnych (angażuje układ immunologiczny kobiety tak, by pozostałe plemniki mogły łatwiej dostać się na "newralgiczne" tereny), a niektóre populacje mają ułatwić całości nasienia przebicie się przez zaporę śluzu szyjkowego. Możliwie precyzyjne wytypowanie tej konkretnej grupy szczególnie predysponowanej do efektywnego połączenia się z komórką jajową i sprawne jej wyizolowanie to zagadnienia, nad którymi prowadzi się rozliczne badania, przy czym poza czysto fizycznymi metodami separacji (np. wirowanie) przeprowadza się coraz częściej także typowanie funkcjonalne, genetyczne, etc. Wiadomo już (dzięki doświadczeniu zdobytemu podczas praktyk wspomaganego rozrodu), że zdolną do zapłodnienia frakcję plemników wyróżnia między innymi ruchliwość, łatwość ulegania kapacytacji (kilkukodzinny proces zachodzący w drogach rodnych, który prowadzi do rozpuszczenia glikoproteinowej osłonki pokrywającej akrosom w szczycie główki plemnika i umożliwia wniknięcie do jajeczka) i - co niby oczywiste, ale warte podkreślenia - prawidłowość budowy, w tym integralność chromatyny, jak dotąd nie znaleziono jednak czynnika, który pojedynczo jednoznacznie weryfikowałaby "przydatność" plemników, umożliwiając w pełni skuteczną selekcję nasienia.

Liczne podejrzenia były związane z istotnością funkcji plemniczych mitochondriów. I to właśnie na ich ocenie skupiła się opublikowana w tym roku w PLoS ONE (Public Library of Science) praca. Jako że metodę cytometrii przepływowej uważa się za nieszkodliwą dla badanych gamet (wykazano, że nie wpływa na ich żywotność), ona właśnie - obok mikroskopii fluorescencyjnej - posłużyła autorom jako główne narzędzie badań. Używając celowanych znaczników fluorescencyjnych sprawdzano poziom błonowego potencjału mitochondrialnego będącego wyznacznikiem odrębności mitochondrium i elementem warunkującym prawidłową jego funkcję. Populacje plemników o różnej wysokości potencjału mitochondrialnego oceniano pod kątem dotychczas znanych czynników świadczących o zdolności do zapłodnienia. Badano plemniki pochodzące od zdrowych dawców spermy (z programów wspomaganego rozrodu) oraz od pacjentów o obniżonej płodności. Okazało się, że rzeczywiście - komórki ze sprawniejszymi mitochondriami (ocenianymi poprzez pomiar potencjału mitochondrialnego) tworzą frakcję plemników o zauważalnie wyższej sprawności, o wyższej ruchliwości, prawidłowej morfologii, łatwo podlegających kapacytacji. Co więcej - udało się substancję chemiczną użytą do oceny potencjału (marker kationowy, MT-G) wykorzystać jako znacznik w sorterze komórkowym, umożliwiając w ten sposób wyizolowanie populacji komórek o wyższym wychwycie MT-G i - według wstępnych ocen - wyższej funkcjonalności. Następnie porównano ekspresję białek mitochondrialnych (w tym enzymów związanych z niezwykle istotnym dla procesów śmierci i przeżywalności komórek cytochromem c) w populacjach o różnym wychwycie znaczników potencjału i zaobserwowano znacznie wyższy ich poziom w komórkach MT-G-dodatnich, co potwierdzałoby teorię o sprawniejszej w tych komórkach pracy mitochondriów. Również proporcja gamet o prawidłowej strukturze i funkcjonalności chromatyny (co potwierdziły m.in. testy dekondensacji chromatyny) i budowie akrosomu była w tych komórkach znacząco większa niż w komórkach MT-G-ujemnych. W porównaniu z tradycyjnymi metodami frakcjonowania spermy, metoda sortowania plemników przy użyciu znaczników mitochondrialnych daje znacznie bogatszą w gamety o wyższej jakości populację, co może znacząco poprawić w przyszłości skuteczność metod wspomaganego rozrodu (w testach zapłodnienia oocytów bydlęcych skuteczność dekondensacji chromatyny niezbędnej do późniejszego połączenia jąder plemnika i komórki jajowej wynosiła 71,9% dla populacji plemników wyizolowanych poprzez ocenę potencjału mitochondrialnego, co jest znaczącą poprawą w stosunku do 43,9% skuteczności zaobserwowanej dla tradycyjnie selekcjonowanych gamet). Być może ocena funkcji mitochondriów wejdzie na stałe do panelu badań nasienia przeznaczonego do procedur zapłodnienia in vitro, jako że mitochondrialny potencjał błonowy zdaje się być bardzo dobrym wskaźnikiem jakości plemników. Liczne podejrzenia były związane z istotnością funkcji plemniczych mitochondriów. I to właśnie na ich ocenie skupiła się opublikowana w tym roku w PLoS ONE (Public Library of Science) praca. Jako że metodę cytometrii przepływowej uważa się za nieszkodliwą dla badanych gamet (wykazano, że nie wpływa na ich żywotność), ona właśnie - obok mikroskopii fluorescencyjnej - posłużyła autorom jako główne narzędzie badań. Używając celowanych znaczników fluorescencyjnych sprawdzano poziom błonowego potencjału mitochondrialnego będącego wyznacznikiem odrębności mitochondrium i elementem warunkującym prawidłową jego funkcję. Populacje plemników o różnej wysokości potencjału mitochondrialnego oceniano pod kątem dotychczas znanych czynników świadczących o zdolności do zapłodnienia. Badano plemniki pochodzące od zdrowych dawców spermy (z programów wspomaganego rozrodu) oraz od pacjentów o obniżonej płodności. Okazało się, że rzeczywiście - komórki ze sprawniejszymi mitochondriami (ocenianymi poprzez pomiar potencjału mitochondrialnego) tworzą frakcję plemników o zauważalnie wyższej sprawności, o wyższej ruchliwości, prawidłowej morfologii, łatwo podlegających kapacytacji. Co więcej - udało się substancję chemiczną użytą do oceny potencjału (marker kationowy, MT-G) wykorzystać jako znacznik w sorterze komórkowym, umożliwiając w ten sposób wyizolowanie populacji komórek o wyższym wychwycie MT-G i - według wstępnych ocen - wyższej funkcjonalności. Następnie porównano ekspresję białek mitochondrialnych (w tym enzymów związanych z niezwykle istotnym dla procesów śmierci i przeżywalności komórek cytochromem c) w populacjach o różnym wychwycie znaczników potencjału i zaobserwowano znacznie wyższy ich poziom w komórkach MT-G-dodatnich, co potwierdzałoby teorię o sprawniejszej w tych komórkach pracy mitochondriów. Również proporcja gamet o prawidłowej strukturze i funkcjonalności chromatyny (co potwierdziły m.in. testy dekondensacji chromatyny) i budowie akrosomu była w tych komórkach znacząco większa niż w komórkach MT-G-ujemnych. W porównaniu z tradycyjnymi metodami frakcjonowania spermy, metoda sortowania plemników przy użyciu znaczników mitochondrialnych daje znacznie bogatszą w gamety o wyższej jakości populację, co może znacząco poprawić w przyszłości skuteczność metod wspomaganego rozrodu (w testach zapłodnienia oocytów bydlęcych skuteczność dekondensacji chromatyny niezbędnej do późniejszego połączenia jąder plemnika i komórki jajowej wynosiła 71,9% dla populacji plemników wyizolowanych poprzez ocenę potencjału mitochondrialnego, co jest znaczącą poprawą w stosunku do 43,9% skuteczności zaobserwowanej dla tradycyjnie selekcjonowanych gamet). Być może ocena funkcji mitochondriów wejdzie na stałe do panelu badań nasienia przeznaczonego do procedur zapłodnienia in vitro, jako że mitochondrialny potencjał błonowy zdaje się być bardzo dobrym wskaźnikiem jakości plemników.

Oryginalny artykuł: Not All Sperm Are Equal: Functional Mitochondria

Characterize a Subpopulation of Human Sperm with Better Fertilization

Potential, Ana Paula Sousa, Alexandra Amaral, Marta Baptista, Renata

Tavares, Pedro Caballero Campo, Pedro Caballero Peregrin, Albertina

Freitas, Artur Paiva, Teresa Almeida-Santos, Joao Ramalho-Santos; PLoS

One. 2011 Mar 23;6(3):e18112.

[Paulina Łopatniuk] | | |

Biologia

Choroby żołądka u gadów bez związku z łapczywym połykaniem (03-06-2011) | Węże i gady znane są ze swojej zdolności do pochłaniania posiłków za jednym zamachem i chociaż można byłoby przypuszczać, że powoduje to spustoszenie w ich układzie trawiennym, wyniki nowych badań europejskich pokazują, że tak naprawdę to infekcja pasożytnicza wywołuje niestrawność u węży i jaszczurek, a nie złe nawyki przeżuwania.

Odkrycia dokonane przez zespół naukowców z Uniwersytetu Medycyny Weterynaryjnej w Wiedniu, Austria, pokazują że to kryptosporydioza, dobrze znana choroba żołądkowo-jelitowa, może napytać gadom poważnych problemów.

Silnie zakaźna choroba, która nie jest zbyt częsta wśród ssaków, jest bardzo powszechna wśród gadów i często ma śmiertelne następstwa. Naukowcy mają nadzieję, że opracowanie sposobów wczesnego diagnozowania umożliwi ograniczenie rozprzestrzeniania się choroby.

Na łamach czasopisma Journal of Veterinary Diagnostic Investigation członkowie zespołu wyjaśniają, jak próbowali przezwyciężyć trudności diagnostyczne związane z chorobą poprzez opracowanie testu identyfikującego kryptosporydię, jednokomórkowego pasożyta, który wywołuje chorobę. To umożliwiło im analizę jej prewalencji wśród domowych jaszczurek i węży.

Kryptosporydioza jest znana naukowcom od ponad wieku, ale dopiero po odkryciu, że atakuje ludzi, postrzeganie choroby zmieniło się z wyjątkowo rzadkiej na taką, która jest powszechniejsza. Ponadto często zdarza się, że chorobotwórczy, jednokomórkowy pasożyt kryptosporydia wywołuje zaburzenia żołądkowo-jelitowe po długim okresie inkubacji i jak dotąd nie wynaleziono na to lekarstwa.

Diagnostyka polega na wykryciu pasożytów w odchodach. Aczkolwiek, jeżeli chodzi na przykład o węże, to proces ten komplikuje nieco fakt, że wydalają one pasożyty połykane wraz z ofiarą. To oznacza, że obecność kryptosporydia w odchodach niekoniecznie oznacza, że dany osobnik jest zarażony. W tym świetle zasadnicze znaczenie ma możliwość rozróżnienia przez naukowców między kryptosporydią powiązaną z ofiarą a tą wywołującą infekcję. Tutaj właśnie do akcji wkracza procedura oparta na DNA, która pozwala na ustalenie zarówno tego, czy kryptosporydia jest obecna oraz tego, czy pochodzi od ssaka czy też od węża.

Zespół zidentyfikował również inny sposób, w którym procedura oparta na DNA może być problematyczna. "Kolejnym problemem jest często bardzo mała liczba kryptosporydii w odchodach, przez co można je łatwo pominąć w pojedynczym teście" - zauważa naczelna autorka Barbara Richter. "Pracujemy nad zwiększeniem czułości naszej metody, ale niezwykle istotne jest wielokrotne testowanie gadów. Ujemny wynik niekoniecznie oznacza, że zwierzę jest naprawdę wolne od pasożyta".

Wyniki zespołu pokazują, że konkretny typ kryptosporydium był obecny w około jednej z sześciu próbek pobranych od popularnego pupila, jakim jest wąż zbożowy. Kryptosporydium było obecne w około 1 z 12 próbek pobranych od gekona lamparciego - jaszczurki, która często gości w kolekcjach gadów.

Wyniki zaskoczyły członków zespołu, gdyż odzwierciedlają skalę rozpowszechnienia choroby. Fakt, że gady gromadzone w kolekcjach są podatne na chorobę jest również niepokojący, a zważywszy na gromadzenie w kolekcji dużej liczby różnych gatunków, istnieje wysokie ryzyko zakażenia międzygatunkowego.

© Unia Europejska 2005-2011

Źródło: CORDIS

Referencje dokumentu: Richter, B., et al. (2011) Detection of Cryptosporidium species in feces or gastric contents from snakes and lizards as determined by polymerase chain reaction analysis and partial sequencing of the 18S ribosomal RNA gene. J VET Diagn Inves | | |

Fizyka

Elektron - kula (prawie) doskonała (01-06-2011) | Najdokładniejszy jak dotąd pomiar elektronu wykonany został przez zespół europejskich naukowców, a wyniki zaskakują sferycznym kształtem elektronu.

W artykule opublikowanym w czasopiśmie Nature naukowcy z Imperial College w Londynie opisują swoje odkrycia dokonane w toku doświadczenia, które trwało ponad dekadę.

Wyniki wskazują, że elektronowi do zakwalifikowania go jako formę doskonale kulistą brakuje zaledwie 0,000000000000000000000000001 cm. Zespół ustalił, że gdybyśmy byli w stanie powiększyć elektron do rozmiaru Układu Słonecznego, to ludzkiemu oku wydałby się on idealnie sferyczny z błędem nieprzekraczającym grubości ludzkiego włosa.

Zespół fizyków przeprowadził badania, przyglądając się elektronom wewnątrz molekuł zwanych fluorkiem iterbu. Naukowcy wykorzystali bardzo precyzyjny laser do pomiarów ruchu tych elektronów.

Udało im się stwierdzić, że elektrony są okrągłe, ponieważ jeżeli elektron nie miałby kształtu sferycznego, chybotałby się w szczególny sposób, wypaczający kształt pozostałej części molekuły niczym niewyważony wirujący bąk. Ponieważ zespół nie dostrzegł żadnego chybotania, wyciągnięto wniosek, że elektrony mają kształt okrągły.

Dr Jony Hudson, jeden ze współautorów artykułu z Wydziału Fizyki Imperial College London, powiedział: "Jesteśmy naprawdę zadowoleni, że udało nam się pogłębić wiedzę o jednym z podstawowych elementów budulcowych materii. To był niezwykle trudny pomiar do wykonania, ale zdobyta wiedza umożliwi nam doskonalenie naszych teorii w obszarze fizyki podstawowej. Ludzie są często zaskoczeni słysząc, że nasze teorie fizyczne nie są 'skończone', ale tak naprawdę są stale dopracowywane i doskonalone, dzięki coraz dokładniejszym pomiarom, takim jak ten właśnie."

Badania te posuwają naprzód rozwiązanie jednej z największych utrzymujących się tajemnic fizyki: dlaczego i jak materia przeważa nad antymaterią? Wedle obecnie przyjętego wśród fizyków myślenia, w czasie Wielkiego Wybuchu powstało tyle samo antymaterii co zwykłej materii. Niemniej odkąd naukowiec Paul Dirac po raz pierwszy wysunął w 1928 r. teorię istnienia antymaterii - nieuchwytnej substancji, która zachowuje się w taki sam sposób, jak zwykła materia poza tym, że ma przeciwny ładunek elektryczny - odkryto jedynie niewielkie jej ilości w źródłach, takich jak promienie kosmiczne i niektóre substancje radioaktywne.

Ustalenie gdzie - i tak naprawdę czy - istnieją jakiekolwiek złoża antymaterii, których dotąd nie odkryto, stanowi główny cel badań w tym obszarze. Naukowcy starają się wyjaśnić ten brak antymaterii, poszukując niewielkich różnic między zachowaniem materii i antymaterii, których nikt dotąd nie zaobserwował.

Jako że w przypadku antymaterii wersją ujemnie naładowanego elektronu jest dodatnio naładowany antyleketron, zwany również pozytronem, naukowcy z Imperial College London mają nadzieję, że pełniejsza wiedza o kształcie elektronu pozwoli im lepiej poznać zachowania pozytronów oraz potencjalne różnice między antymaterią a materią. To będzie cel kolejnego etapu prowadzonych badań.

Współautor artykułu, profesor Edward Hinds, kierownik Centrum Zimnej Materii przy Imperial College London, wypowiedział się na temat konsekwencji tych prac: "Cały świat jest zbudowany niemal całkowicie z normalnej materii z jedynie niewielkimi śladami antymaterii. Astronomowie wyjrzeli na kraniec widzialnego wszechświata i nawet tam zobaczyli tylko materię - żadnych dużych schowków z antymaterią. Fizycy nie wiedzą po prostu, co się stało z całą antymaterią, niemniej badania te mogą nam pomóc w potwierdzeniu lub wykluczeniu niektórych z możliwych wyjaśnień."

Zespół pracuje obecnie nad nowymi metodami schładzania molekuł do skrajnie niskich temperatur, aby udoskonalić pomiary kształtu elektronów i dokładnie kontrolować ruch molekuł. Pozwoli im to na badanie zachowania osadzonych elektronów daleko bardziej szczegółowo niż kiedykolwiek dotąd.

Gdyby naukowcy odkryli, że elektrony nie są okrągłe, stanowiłoby to dowód na to, że zachowania antymaterii i materii różnią się bardziej niż fizycy dotychczas sądzili. Wyjaśniłoby to, w jaki sposób cała antymateria zniknęła z wszechświata, pozostawiając tylko zwykłą materię.

© Unia Europejska 2005-2011

Źródło: CORDIS, Imperial College w Londynie

Referencje dokumentu: Hudson, J.J., et al. (2011) Improved measurement of the shape of the electron. Nature. DOI: 10.1038/nature10104. | | |

Ekologia

Zagrożone czy może jednak niezagrożone? (28-05-2011) | Do tej pory gatunek roślin uznawano za zagrożony wyginięciem, jeżeli zamieszkiwał ograniczony obszar geograficzny i jego populacja była niewielka. Niemniej dzięki nowym badaniom szeregu okazów roślinnych z Ameryki Południowej i Wlk. Brytanii międzynarodowe konsorcjum biologów wykazało, że przyjęcie takich kryteriów prowadzi do błędnego klasyfikowania jako zagrożonych gatunków, które dopiero co pojawiły się na danym obszarze.

Badania, których wyniki opublikowano 24 maja w czasopiśmie PLoS Biology, zostały częściowo dofinansowane przez Europejską Radę ds. Badań Naukowych (ERBN) z budżetu Siódmego Programu Ramowego (7PR) Komisji Europejskiej, a ich współkierownikiem był profesor Vincent Savolainen, pracujący na Wydziale Nauk Przyrodniczych Imperial College London i w Królewskich Ogrodach Botanicznych w Kew, Wlk. Brytania.

Profesor Savolainen wraz z kolegami zgromadził tkanki roślin z regionu państwa przylądkowego - obszaru znanego ze swojej spektakularnie zróżnicowanej roślinności. Analiza molekularna sekwencji kwasu dezoksyrybonukleinowego (DNA) pokazała, że model zagrożenia różni się od występującego w przypadku roślin z Wlk. Brytanii, które są jedną z najlepiej poznanych flor, oraz od modelu znajdującego zastosowanie wobec kręgowców.

"Uzyskane przez nas wyniki kwestionują stosowanie tego samego zestawu kryteriów zagrożeń do wszystkich żywych organizmów we wszystkich regionach" - zauważa profesor Savolainen. "Będziemy być może musieli przemyśleć sposoby precyzyjnego dostrojenia wdrażania kryteriów Czerwonej Księgi, które mają pomóc w szybkiej ocenie zagrożenia - przytłaczające zadanie, które może okazać się nawet pilniejsze, zważywszy na zmiany, jakie obserwujemy w globalnym środowisku."

Czerwona Księga jest przygotowywana co roku przez Międzynarodową Unię Ochrony Przyrody i Jej Zasobów (IUCN) w następstwie szczegółowych przeglądów przeprowadzanych w terenie, zbierania danych i wykorzystywania wiedzy zdobytej w poprzednich latach. Aktualizacja Czerwonej Księgi, opublikowana w 2010 r., podaje zawrotną liczbę 17.390 gatunków - z niemal 50.000 objętych przeglądem - zagrożonych wyginięciem.

Każdego roku zwiększa się liczba roślin i zwierząt dodawanych do listy. Według najnowszych szacunków około 20% roślin kwitnących jest obecnie zagrożonych wyginięciem - chociaż dokładna liczba nie jest znana, ponieważ zaledwie niewielka część tych gatunków została zbadana.

Zagrożenia gatunków roślin zależne są od wielu czynników. Liczne gatunki są ofiarami utraty siedliska z powodu intensyfikacji zagospodarowania terenu i rolnictwa. Inne podupadają w następstwie zanieczyszczenia lub zniszczenia habitatu albo w następstwie konkurowania z gatunkami inwazyjnymi. Jeszcze inne ulegają nowo pojawiającym się chorobom.

"Spowolnienie tempa wymierania stanowi jedno z największych wyzwań ekologicznych naszych czasów - mówi profesor Jonathan Davies z Uniwersytetu McGill w Kanadzie - niemniej identyfikacja najbardziej zagrożonych gatunków może okazać się trudna."

Wyniki badań sugerują, że zagrożenie wyginięciem gatunków roślin jest ściśle powiązane z ich wiekiem. To różnica w stosunku do czynników, które jak sądzono stwarzają zagrożenie dla gatunków zwierząt. Cechy charakterystyczne uznawane za zwiększające zagrożenie wyginięciem to na przykład posiadanie dużego organizmu, który długo osiąga dojrzałość seksualną albo tendencja do wydawania na świat za każdym razem tylko jednego potomka z długimi przerwami pomiędzy kolejnymi urodzeniami.

"W przypadku roślin wykazujemy, że procesy wymierania i specjacji [ewolucyjny proces powstawania nowych gatunków] są powiązane - wydaje się, że najbardziej zagrożone gatunki są często najmłodsze. Młode gatunki mogą się wydawać bardziej zagrożone wymarciem po prostu dlatego, że ich populacje nie miały jeszcze czasu, aby się rozwinąć i rozprzestrzenić" - wyjaśnia profesor Davies."Aczkolwiek możliwe jest również, że niektóre gatunki roślin mogą być skazane na wymarcie już od chwili pojawienia się."

© Unia Europejska 2005-2011

Źródło: CORDIS

Referencje dokumentu: Extinction Risk and Diversification Are Linked in a Plant Biodiversity Hotspot (PLoS Biology) | | |

Różności

Ratowanie dzikich osłów przed wyginięciem (27-05-2011) | Współczesne konie i osły są potomkami dzikiego osła, któremu obecnie grozi wyginięcie. W świetle trwającej nadal działalności człowieka polegającej na niszczeniu siedlisk i polowaniu nasilają się naciski na ratowanie dzikiego osła. Naukowcy pracujący pod kierunkiem Instytutu Badawczego Ekologii Dzikiej Przyrody Uniwersytetu Weterynaryjnego w Wiedniu, Austria, zbadali czynniki związane z utratą tego gatunku. Badania, których wyniki zostały zaprezentowane w czasopiśmie Biological Conservation, dotyczyły sposobów zadbania o jego przetrwanie.

Chociaż w przeszłości dziki osioł zasiedlił wiele obszarów, teraz występuje tylko w Chinach, Indiach, Iranie, Mongolii i Turkmenistanie. Pustynia Gobi w Mongolii zapewnia schronienie o decydującym znaczeniu dla tego gatunku. Profesor Chris Walzer wraz z kolegami z Instytutu Badawczego Ekologii Dzikiej Przyrody zanalizował rozmieszczenie dzikich osłów na Pustyni Gobi i odkrył, że występują one na obszarach, na których średnia produkcja biomasy kształtuje się poniżej 250 gramów węgla na metr kwadratowy rocznie.

Podczas gdy gatunek występował w przeszłości w bardziej urodzajnych regionach, działalność człowieka spustoszyła siedliska tego zwierzęcia i zagroziła jego przetrwaniu. Zwierzęta zostały przepędzone lub zabite przez ludzi, którzy chcieli zapewnić swojemu inwentarzowi żywemu dostęp do pożywienia i wody, bowiem zasoby jednego i drugiego na Pustyni Gobi są skąpe. Choć bardzo odporny, dziki osioł też potrzebuje wody i pożywienia, aby przetrwać w trudnych warunkach pustynnych i stepowych, a został zmuszony do przeniesienia się na obszary, które nie są w stanie go utrzymać.

Na potrzeby badań naukowcy założyli nadajniki radiowe niemal 20 osłom i monitorowali przemieszczanie się zwierząt, aż do chwili odpadnięcia nadajników (które specjalnie tak właśnie zaprojektowano). Uzyskane wyniki potwierdziły, że poszczególne osobniki poruszają się po dużym terenie, jednak trzymają się z daleka od górzystych czy pagórkowatych regionów.

Naukowcy twierdzą, że góry, które przecinają habitat gatunku w Mongolii, utrudniają jego przemieszczanie się. Wykorzystano testy genetyczne do potwierdzenia informacji, że zwierzęta występujące po obydwu stronach gór są tak naprawdę odizolowane od siebie.

Jednak dzięki wysiłkom podejmowanym przez działaczy na rzecz ruchu ochrony przyrody, zespół nie odkrył dowodów na świeże "wąskie gardło genetyczne". Podsumowując, gatunek wykazał stosunkowo wysoki poziom zróżnicowania genetycznego, zarówno w ramach dwóch subpopulacji, jak i między nimi - twierdzą naukowcy.

Niemniej podkreślają, że dane uzyskane za pomocą nadajników radiowych ujawniły, że dzikie osły albo nie były w stanie albo nie chciały przekroczyć barier wzniesionych przez człowieka, w tym linii kolejowej Ułan Bator - Pekin. W konsekwencji około 17.000 kilometrów kwadratowych odpowiedniego siedliska pozostaje niedostępnych dla tych zwierząt. Podobnie niemal 40-letnie ogrodzenie graniczne między Mongolią a Chinami utrzymuje podział populacji dzikiego osła.

Zespół twierdzi, że dziki osioł z Pustyni Gobi skorzystałby na skoordynowanym, międzynarodowym planie ochrony. "Otwarcie ogrodzenia granicznego, przynajmniej w niektórych miejscach, pomogłoby nie tylko azjatyckiemu dzikiemu osłowi, ale także innymi rzadkim ssakom, takim jak wielbłądy dwugarbne czy reintrodukowane konie Przewalskiego."

Wkład w badania wnieśli eksperci z Politechniki Monachijskiej w Niemczech, Instytutu Ekologii i Geografii Xinjiang w Chinach, Laboratorium Ekologii Ssaków Mongolskiej Akademii Nauk i WWF w Mongolii.

© Unia Europejska 2005-2011

Źródło: CORDIS

Referencje dokumentu: Kaczensky, P., et al. (2011) Connectivity of the Asiatic wild ass population in the Mongolian Gobi. Biological Conservation 144: 920-929. DOI: org/10.1016/j.biocon.2010.12.013. | | |

Astronomia

Dziesięć wcześniej nieodkrytych planet dryfuje po Drodze Mlecznej (23-05-2011) | Astronomowie odkryli 10 nowych planet wielkości Jowisza dryfujących w przestrzeni międzygwiazdowej - z dala od światła którejkolwiek z pobliskich gwiazd macierzystych.

Odkrycia dokonał międzynarodowy zespół finansowanych ze środków unijnych naukowców, którzy prowadzili planetarny przegląd mikrosoczewkowy galaktyki Drogi Mlecznej.

Badania, prowadzone przez astronomów z Chile, Japonii, Nowej Zelandii, Polski, USA i Wlk. Brytanii, zostały częściowo dofinansowane z projektu OGLEIV (Eksperyment optycznego soczewkowania grawitacyjnego - nowe granice astronomii obserwacyjnej), który otrzymał grant Europejskiej Rady ds. Badań Naukowych (ERBN) dla doświadczonych naukowców o wartości 2,5 mln EUR z tematu "Pomysły" Siódmego Programu Ramowego (7PR) UE.

W artykule opublikowanym w czasopiśmie Nature zespół sugeruje, że te samotne planety zostały prawdopodobnie wyrzucone z rozwijających się układów planetarnych. Chociaż naukowcy zawsze mieli przeczucie, że swobodnie poruszające się planety istnieją, to z powodu ich odległej lokalizacji - od 10.000 do 20.000 lat świetlnych od Ziemi w kierunku zgrubienia centralnego Drogi Mlecznej - pozostawały one do tej pory nieodkryte.

To odkrycie oznacza, że swobodnie poruszających się planet podobnych do Jowisza, których nie można zobaczyć mogą być jeszcze miliardy w samej tylko galaktyce Drogi Mlecznej. Wedle szacunków zespołu może ich być dwa razy więcej niż gwiazd i mogą być tak powszechne, jak planety krążące po orbitach wokół gwiazd.

"Nasz przegląd jest niczym spis ludności" - mówi David Bennett, współautor artykułu z Uniwersytetu Notre Dame w USA. "Zbadaliśmy część galaktyki i na podstawie tych danych możemy oszacować ogólną liczbę w galaktyce."

Naukowcy byli w stanie zobaczyć w końcu te swobodnie poruszające się planety dzięki mikrosoczewkowaniu grawitacyjnemu, które pojawia się, kiedy jeden obiekt załamie światło odleglejszej gwiazdy. Według teorii względności Alberta Einsteina, kiedy duże obiekty przemieszczają się przed odleglejszą gwiazdą to mogą zadziałać jak soczewki, załamując i wykrzywiając jej światło w taki sposób, że wydaje się jaśniejsza, a przez to widoczna dla astronomów na Ziemi.

W ciągu dwóch lat zespół przeanalizował środkowy obszar Drogi Mlecznej, zwany też "zgrubieniem centralnym", i gromadził dane za pomocą teleskopu do Mikrosoczewkowych Obserwacji w Astrofizyce (MOA) w Nowej Zelandii o szerokości 1,8 m, który co godzinę skanował gwiazdy w centrum naszej galaktyki pod kątem zdarzeń mikrosoczewkowania grawitacyjnego. Bez tego specjalnego teleskopu mikrosoczewkowego badania nie byłyby możliwe, gdyż ta część kosmosu jest widzialna jedynie przy wykorzystaniu tej techniki.

Chociaż w ramach wcześniejszych obserwacji odkryto od 1995 r. ponad 500 planet, były one w większości powiązane z gwiazdami macierzystymi, a wszelkie swobodnie poruszające się duże obiekty zwykle miały masę ponad 3 razy większą od Jowisza. Naukowcy są przekonani, że te ogromne ciała gazowe tworzą raczej gwiazdy niż planety. Nazwane "brązowymi karłami", te podobne do gwiazd kule gazowe powstają z zapadających się kul gazu i pyłu, ale brakuje im masy, aby zapalić swoje paliwo jądrowe i rozbłysnąć światłem gwiazdy.

Podobnie naukowcy sądzą, iż prawdopodobnie niektóre planety są wyrzucane ze swoich wczesnych, burzliwych układów słonecznych z powodu zetknięć grawitacyjnych z innymi planetami lub gwiazdami. Bez gwiazdy macierzystej, po której orbicie mogłyby krążyć, planety te powinny poruszać się po galaktyce jak Słońce i inne gwiazdy, czyli po stabilnych orbitach wokół centrum galaktyki.

David Bennett wyjaśnia, w jaki sposób odkrycie 10 swobodnie poruszających się planet wielkości Jowisza potwierdza teorię wyrzucenia: "Jeżeli swobodnie poruszające się planety powstawałyby jak gwiazdy, wówczas w naszym przeglądzie spodziewalibyśmy się zobaczyć zaledwie jedną czy dwie - ale nie 10. Nasze wyniki sugerują, że układy planetarne często stają się niestabilne, prowadząc do wyrzucania planet z miejsca ich powstania."

Badania te są czwartym etapem projektu OGLE (Eksperyment optycznego soczewkowania grawitacyjnego) - jednego z największych przeglądów nieba na świecie, który jest realizowany od 1992 r.

Do tej pory projekt OGLE pozwolił pogłębić wiedzę w wielu dziedzinach współczesnej astrofizyki, w tym w zakresie mikrosoczewkowania grawitacyjnego, poszukiwania planet spoza układu słonecznego, astrofizyki gwiazdowej i budowy galaktyki. Przegląd OGLE-IV wnosi również wkład w poszukiwania planet karłowatych wielkości Plutona w Pasie Kuipera oraz swobodnie poruszających się czarnych dziur, a także w obserwacje mikrosoczewkowania w Obłokach Magellana i dysku galaktycznym.

© Unia Europejska 2005-2011

Źródło: CORDIS

Referencje dokumentu: Sumi, T., et al. (2011) Unbound or distant planetary mass population detected by gravitational microlensing. Nature. DOI: 10.1038/nature1009. | | |

Astronomia

Gliese 581g - kolejna kandydatka na nową Ziemię (21-05-2011) | Naukowcom z Francji udało się zidentyfikować za pomocą zaawansowanego modelu obliczeniowego pierwszą egzoplanetę, która może nadawać się do zamieszkania. Zaprezentowana w czasopiśmie The Astrophysical Journal Letters planeta Gliese 581d krąży po orbicie czerwonego karła. Jej powierzchnia jest pokryta wodą w postaci płynnej, jej atmosfera jest stabilna a temperatura odpowiednia. Znajduje się w odległości zaledwie około 20 lat świetlnych od Ziemi. Badania zostały częściowo dofinansowane z projektu E3ARTHS (Badania nad atmosferą egzoplanet i Ziemi na wczesnym etapie - teorie i symulacje), który otrzymał grant Europejskiej Rady ds. Badań Naukowych o wartości 720.000 EUR z budżetu Siódmego Programu Ramowego (7PR) UE.

Astrofizycy pracowali od wielu lat nad odkryciem pierwszej planety nadającej się do zamieszkania. W zdecydowanej większości poszukiwania były prowadzone w "ekostrefach" wokół gwiazd, definiowanych przez ekspertów jako zakres odległości, w którym planety nie są ani zbyt gorące ani zbyt zimne, aby mogło na nich istnieć życie.

Czerwony karzeł Gliese wzbudził zainteresowanie trzy lata temu, po tym jak naukowcy z USA ogłosili, że odkryli dwie planety krążące po orbicie rzekomo blisko wewnętrznej i zewnętrznej krawędzi jego ekostrefy. Planeta Gliese 581d znajdowała się najdalej, a przez to uznaną ją za zbyt zimną, by kwitło na niej życie.

Trzy lata później kolejny zespół badawczy ogłosił odkrycie nowej planety o nazwie Gliese 581g. Naukowcy byli przekonani, że masa planety jest podobna do masy Ziemi i że planeta jest położona w pobliżu środka ekostrefy. Niemniej niezależna analiza wykazała później, że tak nie jest.

Niektórzy eksperci utrzymują, że Gliese 581g nie istnieje, sugerując że odkrycie może wynikać tylko z szumu w "ultra precyzyjnych pomiarach kołysania gwiazd", które są nieodzowne w identyfikacji egzoplanet w tym układzie.

W ostatecznym rozrachunku Gliese 581d wydaje się być potencjalnie nadającą się do zamieszkania egzoplanetą. Robin Wordsworth i jego koledzy z Laboratoire de Météorologie Dynamique przy Institut Pierre Simon Laplace we Francji twierdzą, że planeta Gliese 581d ma masę co najmniej 7 razy większą od Ziemi i jest około dwa razy większa.

Aby ustalić czy Gliese 581d jest dobrą kandydatką, zespół opracował model komputerowy potrafiący symulować możliwe klimaty egzoplanet. Miało to szczególnie znacznie, ponieważ nie było wiadomo, czy planeta byłaby w stanie oprzeć się globalnym zlodowaceniom i/lub załamaniu atmosferycznemu. Naukowcy twierdzą, że otrzymuje ona 35% mniej energii gwiezdnej od Marsa. Niemniej trójwymiarowe symulacje klimatyczne pokazały, że Gliese 581d posiada powierzchniową warstwę ciekłej wody i stabilną atmosferę, "przez co jest pierwszą, potwierdzoną superziemią (egzoplanetą o masie od 2 do 10-krotności Ziemi) w ekostrefie".

Klimat planety jest nie tylko zabezpieczony przed załamaniem, ale jego odpowiednie temperatury mogą pozwalać na istnienie oceanów, chmur i opadów deszczu. Należy zauważyć, że symulacje ujawniły również, iż atmosfera sprawnie rozprowadza ciepło światła dziennego, utrzymując pod kontrolą wszelkie załamania atmosferyczne po odpowiedniej stronie lub na biegunach.

Naukowcy twierdzą, że na podstawie promieniowania podczerwonego emitowanego w modelu, "proponują testy obserwacyjne, które umożliwią odróżnianie w przyszłości takich przypadków od innych możliwych scenariuszy".

Podchodzą entuzjastycznie do Gliese 581d jako jednego z najbliższych galaktycznie sąsiadów Ziemi. Choć nieodzowne są dalsze prace, naukowcy uzyskają potrzebne narzędzia do pozyskiwania niezbędnych informacji o tej planecie, którą być może da się skolonizować.

Wkład w badania wnieśli eksperci z Centre National de la Recherche Scientifique (CNRS) i Université de Bordeaux we Francji.

© Unia Europejska 2005-2011

Źródło: CORDIS

Referencje dokumentu: Wordsworth, R.D., et al. (2011) Gliese 581d is the first discovered terrestrial-mass exoplanet in the habitable zone. The Astrophysical Journal, publikacja z dnia 12 maja. DOI: 10.1088/2041-8205/733/2/L48. | | |

Kosmologia

Teleskop Einsteina - projekt nowego detektora fal grawitacyjnych (21-05-2011) | Dnia 20 maja 2011 r. europejscy naukowcy zaprezentowali nową infrastrukturę badawczą, która zapewni Europie czołowe miejsce w najbardziej obiecujących przedsięwzięciach związanych z dążeniami człowieka do poznania pochodzenia wszechświata. Naukowcy zjednoczeni w wysiłkach na rzecz wykrycia owych zmarszczek czasu i przestrzeni zaprezentują swoje prace w Europejskim Obserwatorium Grawitacyjnym (EGO) w Pizie, Włochy.

"Po trzech latach badań, w które zaangażowało się ponad 200 naukowców z Europy i ze świata, mamy przyjemność zaprezentować projekt Teleskopu Einsteina, który otwiera drogę do odsłonięcia ukrytej strony wszechświata" - powiedział Harald Lück, zastępca koordynatora naukowego projektu Teleskop Einsteina.

Komisja Naukowa przeznaczyła na wstępne badania nad opracowaniem Teleskopu Einsteina - detektora fal grawitacyjnych trzeciej generacji - 3 mln EUR z budżetu Siódmego Programu Ramowego (7PR) w ramach działania "Infrastruktury badawcze" programu "Możliwości". W ich toku zostaną ustalone wymagania techniczne wymaganego stanowiska oraz infrastruktura, niezbędne technologie i szacunkowe koszty.

"Komisja Europejska dostrzegła wagę nauki badającej fale grawitacyjne, która rozwinęła się w Europie, jej wartość dla badań podstawowych i technologicznych oraz stworzyła wspólne ramy dla naukowców europejskich zajmujących się badaniami fal grawitacyjnych" - zauważa Federico Ferrini, dyrektor EGO.

Wykrywanie fal grawitacyjnych będzie dla ogólnej teorii względności Einsteina treningiem, jakiego nigdy wcześniej nie miała. Wspomniane zmarszczki czasu i przestrzeni umożliwią naukowcom dokładne wsłuchanie się w najgwałtowniejsze wydarzenia we wszechświecie, kolizje czarnych dziur. Dźwięki wszechświata pozwolą im również eksplorować czasy i miejsca, których nie można zobaczyć w zwykłym świetle, jak np. narodziny wszechświata.

Fale grawitacyjne wymykały się dotychczas próbom wykrycia podejmowanym przez naukowców na całym świecie. W związku z tym, że będzie to obserwatorium trzeciej generacji, czułość Teleskopu Einsteina będzie 100 razy większa od obecnych detektorów fal grawitacyjnych, zwiększając milion razy obserwowalny wolumen wszechświata.

"Obserwatorium, które osiągnie taki poziom czułości sprawi, że wykrywanie fal grawitacyjnych stanie się rutynowym narzędziem astronomicznym. Teleskop Einsteina stanie na czele rewolucji naukowej" - zauważa Michele Punturo, koordynator naukowy badań projektowych nad Teleskopem Einsteina.

Ze wszystkich fal i cząstek znanych fizykom, fale grawitacyjne najmniej wchodzą w interakcje. Mogą zatem zawierać informacje z najwcześniejszych momentów wszechświata, kiedy było tak gęsty, że ani światło ani neutrina nie były w stanie się wymknąć. Na przykład fale radiowe kosmicznego mikrofalowego promieniowania tła wydostały się, kiedy wszechświat miał 300.000 lat. Fale grawitacyjne rozpoczęły swoją podróż do nas, kiedy wszechświat istniał krócej niż 10-35 sekundy.

Z drugiej strony, podobnie jak fale elektromagnetyczne, także i grawitacyjne obejmują szerokie spektrum. Teleskop Einsteina będzie służyć do bezpośredniego wykrywania fal o częstotliwości od 1 Hz do 10 kHz. Przy niższych częstotliwościach dezorientujący pierwszy plan generowany przez źródła astrofizyczne jest zbyt silny. Przy wyższych częstotliwościach, w których muszą pracować naziemne detektory fal grawitacyjnych, oczekiwany sygnał staje się zbyt słaby do wykrycia. Między tymi granicami otwierają się możliwości lepszego poznania pochodzenia wszechświata.

© Unia Europejska 2005-2011

Źródło: CORDIS

Karta informacji o projekcie Teleskop Einsteina w serwisie CORDIS | | |

Ewolucja

Cykl mocznikowy przyczyną sukcesu ewolucyjnego okrzemków (16-05-2011) | Mimo swojej wszechobecności i zróżnicowanych ról, okrzemki morskie - główny komponent fitoplanktonu występującego obficie w oceanie, tworzący tym samym podstawę morskiego łańcucha pokarmowego - pozostają owiane tajemnicą. Niedawno finansowane ze środków unijnych międzynarodowe konsorcjum naukowców odkryło, że co najmniej jeden gatunek okrzemków - Phaeodactylum tricornutum - wykorzystuje ścieżkę molekularną stwierdzoną wcześniej jedynie u ssaków, mianowicie cykl mocznikowy.

Badania, których wyniki opisano w czasopiśmie Nature z 12 maja, zostały częściowo dofinansowane z projektu DIATOMICS (Zrozumienie biologii okrzemków poprzez metodologie genomiki funkcjonalnej), który otrzymał 1,8 mln EUR z tematu "Nauki o życiu, genomika i biotechnologia na rzecz zdrowia" Szóstego Programu Ramowego (6PR) Komisji Europejskiej.

Cykl mocznikowy to ścieżka metaboliczna wykorzystywana przez ssaki do odprowadzania nadmiaru azotu do mocznika i usuwania go z organizmu. Jednak wydaje się on pełnić znacznie szerzej nakreśloną rolę u okrzemków. W ich przypadku cykl mocznikowy ma kluczowe znaczenie dla rozprowadzania i recyklingu węgla nieorganicznego i azotu oraz wspomaga okrzemki w dochodzeniu do siebie po krótkotrwałych niedoborach substancji odżywczych.

Różne okrzemki żyjące pośród kryształków lodu (McMurdo Sound, Antarktyka). Obraz cyfrowy uzyskany z oryginalnych slajdów 35 mm Ektachrome (1983), źródło: NOAA Photo Library

Naukowcy odtworzyli w laboratorium zjawisko upwellingu obserwowane w oceanach. Polega ono na ruchu wznoszącym wody bogatej w substancje odżywcze z głębin oceanu na powierzchnię, gdzie są rozprowadzane w dużych ilościach. Okrzemki zareagowały niezwłocznie na dostępność zwiększonej ilości pożywienia poprzez przyspieszenie tempa metabolizmu i rozwoju.

Odpowiedzialne za tę zdolność uznaje się geny, które znalazły się w genomie okrzemków za pośrednictwem poziomego transferu - ruchu genów między luźno spokrewnionymi organizmami. W toku wcześniejszych badań naukowcy odkryli, że niektóre z genów okrzemków mają odpowiedniki w chloroplastach i bakteriach, co stanowi dowód na to, jak wiele jeszcze pozostaje niewiadomych w stosunku do tych wieloaspektowych organizmów.

Posuwając się o krok dalej na tej ścieżce badań, naczelny autor artykułu dr Andrew Allen z Instytutu J. Craiga Ventera w USA wraz z kolegami zbadał mechanizmy komórkowe wykorzystywania substancji odżywczych w środowisku. Dzięki temu odkryto, że metabolity cyklu mocznikowego ułatwiają okrzemkom dochodzenie do siebie po krótkotrwałym niedoborze substancji odżywczych.

"Wydaje się, że cykl mocznikowy u zwierząt, który ma zasadnicze znaczenie dla eksportu komórkowego odpadów węglowych i azotowych, został przejęty z pradawnej ścieżki, wykształconej pierwotnie jako mechanizm recyklingu i odzyskiwania azotu i węgla" - wyjaśnia dr Allen. Innymi słowy okrzemki przeszły zasadniczo odmienną ścieżkę ewolucyjną niż zielenice czy inne blisko spokrewnione organizmy.

"Badania te przynoszą fascynujące informacje na temat sposobu, w jaki okrzemki ewoluowały, aby stać się dominującymi, podstawowymi producentami na wielu obszarach oceanicznych" - dodaje dr David Garrison, dyrektor programu z Wydziału Nauk Oceanicznych Krajowej Fundacji Nauki w USA, która dofinansowała badania wraz z Komisją Europejską.

Okrzemki znajdują się na początku morskiego łańcucha pokarmowego i przypisano im absorpcję takich ilości dwutlenku węgla - głównego gazu cieplarnianego - jakie są wchłaniane przez wszystkie tropikalne lasy deszczowe na świecie. Poza odżywianiem wszelkiego typu zwierząt i pomocą w utrzymywaniu bilansu węglowego planety, te jednokomórkowe organizmy są również cenione przez naukowców za wskaźniki tego, czy woda jest uboga w minerały i substancje odżywcze albo zanieczyszczona.

© Unia Europejska 2005-2011

Źródło: CORDIS

Referencje dokumentu: Allen, A. E., et al. (2011) Evolution and metabolic significance of the urea cycle in photosynthetic diatoms, Nature, publikacja z dnia 12 maja. DOI: 10.1038/nature10074

| | |

Ewolucja

Kiedy rośliny tworzą nowe gatunki (16-05-2011) | Wbrew powszechnej opinii, tempo specjacji roślin nie jest powiązane z uprzednim pojawieniem się nowej cechy fizycznej lub mechanizmu. Wyniki nowych badań międzynarodowych pokazują, że rośliny majstrują przy ustawieniach swojej wydajności i konfiguracji, aby tworzyć ulepszone wersje samych siebie. Odkrycia zaprezentowano w czasopiśmie American Journal of Botany.

Naukowcom z Heidelberskiego Instytutu Badań Teoretycznych (HITS) w Niemczech wraz z kolegami z Uniwersytetów Browna i Yale w USA udało się zrekonstruować filogenię roślin - historię zmian rodów organizmów na przestrzeni czasu. Dzięki rekonstrukcji drzewa życia, niemieccy i amerykańscy naukowcy rzucili nowe światło na proces ewolucji.

Rzeczą, która od pewnego czasu wprowadzała naukowców w konsternację był moment, kiedy klady rozpoczynają wykształcanie nowych gatunków. Klady to grupa roślin mających tego samego przodka. Naukowcy byli przekonani, że szybka specjacja zachodziła po rozwinięciu przez klady najpierw nowej cechy fizycznej lub mechanizmu, aby następnie rozpocząć tworzenie własnej gałęzi genetycznej.

Zdaniem zespołu najnowsze badania pokazują, że dopiero po osiągnięciu przez rośliny kwitnące etapu rozwoju, na którym powodzenie i tempo specjacji będą zoptymalizowane, główne rody roślin rozpoczynają szybkie wykształcanie nowych gatunków.

"Ewolucja nie jest taka, jaka wcześniej sądziliśmy" - wyjaśnia dr Stephen Smith, naukowiec z Uniwersytetu Browna, afiliowany również w HITS i naczelny autor artykułu. "To nie jest tak, że kiedy pojawia się kwiat to (szybko) zachodzi specjacja. Jest opóźnienie. I dzieje się coś innego. A mianowicie dochodzi jak gdyby do etapu rozwoju produktu."

Zatem jakie podejście jest najlepsze, aby dotrzeć do sedna tego zagadnienia? Zespół stwierdził, że kluczową rolę odgrywają tutaj metody obliczeniowe. "To dobry przykład tego, jak informatyka i inicjatywy w zakresie cyberinfrastruktury mogą przyczynić się do poszerzenia granic badań biologicznych" - wskazuje Alexandros Stamatakis z HITS, jeden z autorów artykułu.

Zespół obliczył największe drzewo ewolucyjne z uwzględnieniem 55.473 gatunków roślin kwitnących (tj. okrytozalążkowych). Linia genealogiczna obejmuje około 90% wszystkich roślin występujących na naszej planecie.

Naukowcy przeanalizowali profile genetyczne sześciu głównych kladów okrytozalążkowych, a mianowicie trawy (Poaceae), storczykowate (Orchidaceae), astrowate (Asteraceae), bobowate (Fabaceae), dwuliścienne właściwe (Eudicotyledoneae) i jednoliścienne (Monocottyledoneae). Stwierdzili, że Mesangiospermae - klad, który pojawił się ponad 125 mln lat temu - był wspólnym przodkiem tych gałęzi. Niemniej odkryli, że specjacja pojawiła się dopiero po pewnym czasie, a nie wokół prakorzenia. Należy zauważyć, że zespół nie był w stanie ustalić konkretnego momentu.

"Na wczesnym etapie ewolucji tych grup następuje rozwój cech, które często rozpoznajemy w celu ich wizualnej identyfikacji, niemniej ich szybka specjacja następuje dopiero po wykształceniu się tych cech" - zauważa dr Smith.

W artykule czytamy: "Te odkrycia są spójne z poglądem, że radiacje zazwyczaj rozpoczynają się długim 'lontem', a także z koncepcją, że początkowa innowacja umożliwia dalsze eksperymentowanie i ostatecznie ewolucję połączenia cech charakterystycznych, które napędzają główną radiację."

Przyszłe badania będą dążyć do ustalenia wyzwalaczy dobrodziejstwa specjacji i przyniosą informację o tym, jak rośliny rozwijają się szybciej i dystansują swoich "rówieśników".

© Unia Europejska 2005-2011

Źródło: CORDIS

Referencje dokumentu: Smith, S.A., et al. (2011) Understanding angiosperm diversification using small and large phylogenetic trees. American Journal of Botany. DOI: 10.3732/ajb.1000481. | | |

Ewolucja

Czego nauczyliśmy się od bakterii? (14-05-2011) | Wyniki najnowszych badań prowadzonych na myszach pozwalają zrozumieć, w jaki sposób pospolite bakterie jelitowe chronią się przed działaniem systemu immunologicznego organizmu gospodarza. Odkrycie pomoże zrozumieć, w jaki sposób system immunologiczny odróżnia szkodliwe bądź chorobotwórcze mikroorganizmy od tych, których obecność jest korzystna, a nawet niezbędna dla zdrowia.

Ocenia się, że w jelitach bytuje biliony bakterii. Ich obecność wspiera proces trawienia, zapobiega zakażeniom, wpływa na ryzyko wystąpienia chorób autoimmunologicznych. Dobroczynne bakterie stosunkowo rzadko są atakowane przez system immunologiczny gospodarza, podczas gdy inne bakterie, na przykład salmonella, wywołują silną odpowiedź immunologiczną. W jaki sposób system immunologiczny "wie", które z mikroorganizmów należy zaatakować, a które pozostawić w spokoju, zwłaszcza w sytuacji gdy wróg i przyjaciel wyglądają całkiem podobnie, długo pozostawało zagadką.

W poszukiwaniu odpowiedzi na to pytanie zespół badawczy pracujący pod kierunkiem dr Sarkisa K. Mazmaniana z California Institute of Technology postanowił przyjrzeć się Bacteroides fragilis - zazwyczaj nieszkodliwej bakterii komensalnej, bytującej m.in. w jelitach myszy. Badania zostały częściowo sfinansowane przez amerykański Narodowy Instytut Cukrzycy, Chorób Układu Trawiennego i Nerek (NIDDK) oraz Narodowy Instytut Alergii i Chorób Zakaźnych (NIAID). Raport z badań został opublikowany na łamach Science w wydaniu z dnia 21 kwietnia br.

Aby ustalić, w jaki sposób bakterii udaje się uniknąć ataku ze strony układu immunologicznego organizmu gospodarza, naukowcy zajęli się badaniami nad wyjałowionymi myszami, których układ pokarmowy został skolonizowany przez Bacteroides fragilis. Nie odnotowano znaczącego wzrostu ilości limfocytów Th17 - komórek układu odpornościowego, niezbędnych w procesie eliminacji patogenów.

W tym miejscu można wspomnieć, że we wcześniejszych badaniach Mazmanionowi udało się wykazać, że Bacteroides fragilis korzysta z ochrony Polisacharydu A (PSA). Usunięcie PSA z bakterii prowadzi do wystąpienia odpowiedzi na obecność bakterii ze strony limfocytów Th17.

Z kolei aby odpowiedzieć na pytanie, w jaki sposób Bacteroides fragilis tłumi odpowiedź limfocytów Th17, naukowcy doprowadzili do wyłączenia niektórych elementów zwierzęcego systemu odpornościowego. Przekazywanie sygnałów za pośrednictwem receptorów Toll-podobnych (TLR) jest wykorzystywane zarówno w aktywacji, jak i tłumieniu odpowiedzi immunologicznej, a wspomniany już PSA działa właśnie za pośrednictwem receptora Toll-podobnego 2 (TLR2).

Wyłączenie receptorów TLR2 prowadziło u myszy do wzrostu ilości limfocytów Th17, które zapobiegały kolonizacji jelit przez Bacteroides fragilis. Limfocyty T regulatorowe (T reg), działają supresyjnie na Th17, co zapobiega atakowaniu tkanek organizmu przez własny układ odpornościowy. Gdy naukowcy unieczynnili mysie komórki T reg, obserwowano wzrost ilości Th17 i w konsekwencji spadek ilości bakterii w jelitach.

Naukowcy sądzili wcześniej, że jelitowe bakterie komensalne unikały wykrycia ze strony układu immunologicznego gospodarza, bytując w świetle jelit, z dala od ich powierzchni. Jednak badania zużyciem mikroskopii trójwymiarowej pozwoliły zespołowi dr Mazmaniana ustalić, że bakterie gatunku Bacteroides fragilis bytują w obrębie błony śluzowej okrężnicy, gdzie pozostają narażone na kontakt z systemem immunologicznym organizmu gospodarza.

Wyniki badań wskazują, że Bacteroides fragilis udaje się uniknąć ataku ze strony układu immunologicznego poprzez wywołanie aktywacji komórek T reg. Bakteria dokonuje tego za pomocą PSA, który jest wykrywany w jelitach przez receptory TLR2.

"Są to bakterie, które zamieszkują wewnątrz nas przez całe życie, a więc wyewoluowały w taki sposób, by wyglądać i zachowywać się jak my, jak część nas" - zauważa dr Mazmanian. "Jeżeli chodzi o system immunologiczny, to białka wytwarzane przez bakterie jelitowe powinny być tolerowane na równi z naszymi własnymi białkami. W tym konkretnym przypadku bakterie nauczyły nas, w jaki sposób mamy je tolerować, dla ich własnej i naszej korzyści".

aut. Amy Alabaster

[tłum./oprac. C. O. Reless]

Referencje dokumentu: NIH Research Matters - The Toll-Like Receptor 2 Pathway Establishes Colonization by a Commensal of the Human Microbiota | | |

Antropologia

Neandertalczycy wyginęli wcześniej niż dotychczas sądzono? (11-05-2011) | Naukowcy z Irlandii i Rosji odkryli, że Neandertalczycy prawdopodobnie wymarli wcześniej niż się powszechnie uważa. Badania, których wyniki zostały zaprezentowane w czasopiśmie PNAS Online Early Edition, przedstawiają w nowym świetle teorię, według której powiązania między Neandertalczykami a współczesnymi ludźmi istniały przez tysiące lat. Odkrycia sugerują, że interakcje między nimi nie były ani nieograniczone, ani długofalowe, a współistnienie Neandertalczyków i współczesnych ludzi trwało zaledwie kilkaset lat. Istnieje nawet możliwość, że na niektórych obszarach Neandertalczycy wymarli zanim anatomicznie współcześni ludzie wyemigrowali z Afryki.

Eksperci z University College Cork w Irlandii i Uniwersytetu Oksfordzkiego w Wlk. Brytanii we współpracy z naukowcami z Laboratorium Prehistorii w Petersburgu w Rosji przeprowadzili badania w jaskini Mezmaiskaya, która znajduje się na północno-zachodnim pogórzu Kaukazu w Rosji.

Na tym obszarze zespół odkrył skamielinę dziecka późnych Neandertalczyków z późnego paleolitu środkowego i szereg powiązanych ze sobą kości zwierzęcych. Twierdzą, że skamielina liczy sobie 39.700 lat, sugerując że Neandertalczycy nie przetrwali w jaskini dłużej.

Mówiąc krótko, dane poddają w wątpliwość żywione przez naukowców od dawna przekonania na temat Neandertalczyków i ich przetrwania. Późni Neandertalczycy nie przetrwali na północnym Kaukazie do momentu późniejszego niż 30.000 lat temu, a zatem mało prawdopodobne jest, aby Neandertalczycy i współcześni ludzi współistnieli przez jakikolwiek znaczący czas.

Bogatsi o te nowe informacje, naukowcy są przekonani o tym, że miał miejsce jeden z dwóch rozwojów wypadków: albo Neandertalczycy wymarli kiedy pojawili się współcześni ludzie, albo inne czynniki, w tym zmiana klimatu lub kurczące się zasoby, doprowadziły do ich zagłady przed przybyciem współczesnych ludzi.

Naukowcy twierdzą, że dane wymagają zrewidowania, modyfikacji i udoskonalenia, jeżeli mają wyłonić się z nich precyzyjne chronologie. Da to możliwość dokładnej oceny możliwych powiązań między wymarciem Neandertalczyków, rozprzestrzenieniem się wczesnych ludzi współczesnych i zdarzeniami klimatycznymi.

Zespół podkreśla, że wcześniejsze procesy datowania wydają się "systemowo niedoszacowywać" faktycznego wieku osadów, skamielin i artefaktów późnego paleolitu środkowego i wczesnego paleolitu górnego o około kilka tysięcy lat.

"Teraz znacznie wyraźniej widać, że Neandertalczycy i anatomicznie współcześni ludzie nie współistnieli na Kaukazie i wydaje się możliwe, że ten scenariusz dotyczy również większości regionów w Europie" - mówi dr Ron Pinhasi z University College Cork, naczelny autor raportu z badań. "Wiele z wcześniejszych danych na temat siedlisk lub stanowisk późnych Neandertalczyków w całej Europie wydaje się być problematycznych. To wynika po prostu z faktu, że powiązanie między datowanym materiałem a późnymi Neandertalczykami nie zawsze jest wyraźne, gdyż nie zawsze możemy mieć pewność, czy archeologiczne skupiska narzędzi kamiennych, takie jak mustierskie, przypisane w przypadku Europy Neandertalczykom, nie były w niektórych przypadkach tak naprawdę dziełem ludzi współczesnych. Aby znaleźć odpowiedź musimy bezpośrednio datować skamieliny Neandertalczyków i anatomicznie współczesnych ludzi".

Dr Tom Higham z Uniwersytetu Oksfordzkiego, współautor artykułu, powiedział: "Najnowsze techniki datowania umożliwiają bardzo skuteczne oczyszczanie kolagenu pozyskanego z niewielkich fragmentów skamieliny bez skażania go. Uprzednio zespoły badawcze podawały wcześniejsze daty, o których wiemy, że nie były do końca wiarygodne, gdyż prawdopodobnie skamieliny były zanieczyszczone bardziej współczesnymi cząstkami. Najnowsze dowody uzyskane na podstawie datowania rzucają więcej światła na okres wymarcia Neandertalczyków w tym kluczowym regionie, który jest postrzegany powszechnie jako rozdroże dla ruchu współczesnych ludzi w kierunku rozleglejszych równin rosyjskich. Wymarcie Neandertalczyków jest zatem, w naszym przekonaniu, wskaźnikiem tego, kiedy to miało miejsce po raz pierwszy".

© Unia Europejska 2005-2011

Źródło: CORDIS

Referencje dokumentu: Pinhasi, R., et al. (2011) Revised age of late Neanderthal occupation and the end of the Middle Paleolithic in the northern Caucasus. PNAS Online Early Edition, publikacja z dnia 9 maja. DOI: 10.1073/pnas.1018938108. |

Archiwum (starsze -> nowsze) [1] [2] [3] [4] [5] [6] [7] [8] [9] [10]

[11] [12] [13] [14] [15] [16] [17] [18] [19] [20]

[21] [22] [23] [24] [25] [26] [27] [28] [29] [30]

[31] [32] [33] [34] [35] [36] [37] [38] [39] [40]

[41] [42] [43] [44] [45] [46] [47] [48] [49] [50]

[51] [52] [53] [54] [55] [56] [57] [58] [59] [60]

[61] [62] [63] [64] [65] [66] [67] [68] [69] [70]

[71] [72] [73] [74] [75] [76] [77] [78] [79] [80]

[81] [82] [83] [84] [85] [86] [87] [88] [89] [90]

[91] [92] [93] [94] [95] [96] [97] [98] [99] [100]

|

|

Do treści

Do treści Do treści

Do treści