|

Chcesz wiedzieć więcej?

Zamów dobrą książkę.

Propozycje Racjonalisty: | | |

|  |

Złota myśl Racjonalisty: "Pokarmem umysłu jest poznawanie. Żądza nie trwania czy przetrwania, jak mówisz, lecz pędu, postępu, odkrywania nowych prawd, wydobywanie ich z głębin ziemi, z tkanki roślin, z atomów i z bezmiarów gwiazd, z własnych myśli wreszcie. Poznawanie wszechświata, poznawanie siebie i poznawanie swojej roli we wszechświecie. Tu jest źródło wszelkiej wiedzy, tu kryje się motor nauki. I jakże możesz zmusić.. |  |

|  |

|

|

|

|

Nowinki i ciekawostki naukowe Archiwum nowinek naukowych

Chemia

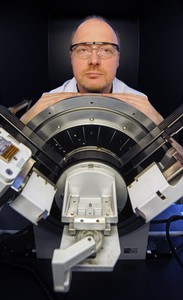

Żele oszukują badaczy (22-03-2012) |  | | 1. Dr Roman Luboradzki z Instytutu Chemii Fizycznej PAN przy

dyfraktometrze rentgenowskim wykorzystywanym w badaniu struktury

krystalicznej kserożeli. (Źródło: IChF PAN, Grzegorz Krzyżewski) |

W jaki sposób jedna cząsteczka substancji żelującej potrafi

unieruchomić nawet kilka tysięcy cząsteczek rozpuszczalnika? Poznanie

mechanizmu odpowiedzialnego za żelowanie może otworzyć drogę do

opracowania nowych materiałów oraz bezpieczniejszych sposobów transportu

cieczy groźnych dla otoczenia. Struktura żeli jest jednak trudna do

bezpośredniego badania, co udowadniają eksperymenty przeprowadzone w

Instytucie Chemii Fizycznej Polskiej Akademii Nauk w Warszawie.

U wejścia do portu dochodzi do zderzenia dwóch tankowców wypełnionych

ropą. Czy gigantyczna katastrofa ekologiczna jest nieunikniona? Dziś

najbardziej prawdopodobna odpowiedź brzmi: tak. W przyszłości efektem

zderzenia może być tylko pogięty metal. Ropa nie wypłynie, ponieważ

wewnątrz zbiornika będzie miała postać żelu.

"Transport niebezpiecznych cieczy w formie zżelowanej to obecnie

fantazja. Nie można jednak wykluczyć, że w przyszłości uda się opracować

związki żelujące, które pozwolą zwiększyć bezpieczeństwo. Ale aby to się

stało, musimy najpierw dokładnie poznać wewnętrzną strukturę żeli oraz

mechanizmy rządzące ich powstawaniem", mówi dr Roman Luboradzki z IChF

PAN.

Żele to układy przypominające wyglądem mniej lub bardziej sprężystą

galeretę. Zazwyczaj są dwuskładnikowe: jeden składnik pełni rolę

rozpuszczalnika, drugi - czynnika żelującego. W procesie żelowania

(polegającym na schłodzeniu ciekłej mieszaniny obu składników) czynnik

żelujący tworzy w przestrzeni żelu rozległą sieć, która unieruchamia

rozpuszczalnik. Sieć najczęściej składa się z amorficznych struktur

przypominających nitki lub tasiemki, rzadziej są to stykające się

konstrukcje sferyczne.

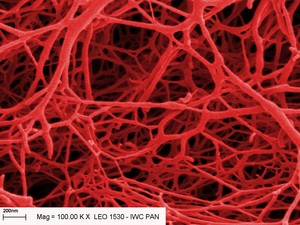

| | 2. Amorficzna struktura kserożelu na zdjęciu ze skaningowego mikroskopu

elektronowego. Kolory sztuczne. (Źródło: IChF PAN) |

W żelach chemicznych cząsteczki czynnika żelującego łączą się ze sobą

za pomocą silnych wiązań kowalencyjnych i tworzą bardzo sztywne i trwałe

struktury. Żele fizyczne, badane w IChF PAN, powstają na odmiennej

zasadzie. Czynnik żelujący, którym zwykle jest jakaś substancja

organiczna, zawiera małe cząsteczki, liczące od kilkunastu do

kilkudziesięciu atomów (stąd nazwa: Low Molecular Mass Organic Gelators,

LMOG). Cząsteczki te łączą się w długie struktury oddziałując ze sobą za

pomocą słabych oddziaływań, takich jak wiązania wodorowe, oddziaływania

pi-pi, siły van der Waalsa itp. Przejście żelu fizycznego w ciecz i

cieczy w żel to procesy odwracalne. Zwykle zachodzą bardzo szybko, przy

zmianie temperatury o zaledwie 1-2 stopnie w pobliżu wartości

krytycznej.

Analizowanie struktury żeli, zwłaszcza typu LMOG, jest trudnym

zadaniem. Oba składniki żelu często charakteryzują się zbliżoną

przezroczystością, a szczegóły struktury sieci mają rozmiary rzędu co

najwyżej kilkunastu-kilkudziesięciu nanometrów. Żelu o takiej budowie

nie można obejrzeć pod mikroskopem optycznym. Skaningowa mikroskopia

elektronowa (SEM) wymaga natomiast umieszczenia próbki w próżni. Wymóg

ten oznacza, że żel należy najpierw odpowiedno przygotować do badań.

Aby zagwarantować zachowanie struktury czynnika żelującego pod

mikroskopem SEM, naukowcy stosują dwie metody. Pierwsza polega na

umieszczeniu próbki żelu w pompie próżniowej. W obniżonym ciśnieniu

rozpuszczalnik szybko paruje, pozostawiając utrwalony czynnik żelujący,

zwykle wyglądający jak biały puder. Tak powstała struktura jest nazywana

kserożelem. Kserożele otrzymuje się również z użyciem sublimacji. W tym

przypadku próbkę zamraża się w ciekłym azocie. Zakłada się przy tym, że

proces zamrażania próbki przebiega tak szybko, że struktura sieci

tworzonej przez czynnik żelujący się nie zmienia. Zamrożona próbka

trafia następnie do komory próżniowej, gdzie rozpuszczalnik stopniowo

sublimuje.

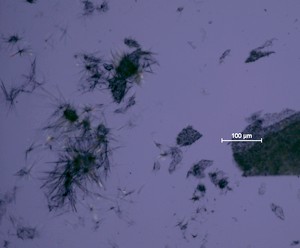

| | 3. Zmiany zachodzące w jednym z kserożeli wraz ze wzrostem temperatury.

Widać gwałtowne formowanie struktur krystalicznych i bardzo szybkie

przejście w stan ciekły. Temperatura między pierwszą a ostatnią klatką

zmieniła się o 96 stopni Celsjusza. (Źródło: IChF PAN) |

"Problem w tym, że na niektórych obrazach z mikroskopu SEM widać

kryształy w kserożelach, w których teoretycznie być ich nie powinno. Nie

wiedzieliśmy, czy kryształy te są rzeczywistą częścią struktury żelu,

czy skutkiem procedury przygotowywania próbki do badań mikroskopowych.

Dlatego postanowiliśmy sprawdzić, jak zmienia się struktura kserożelu

pod wpływem czasu i w zależności od sposobu przygotowywania próbek dla

mikroskopu", mówi dr Luboradzki.

Wyniki otrzymane w Instytucie Chemii Fizycznej PAN wskazują, że nie

zawsze to, co widać pod skaningowym mikroskopem elektronowym, odpowiada

pierwotnej strukturze czynnika żelującego w żelu.

Niezbędnym etapem przygotowania próbki do badania pod mikroskopem SEM

jest napylenie na nią warstwy przewodzącej. Ponieważ proces wiąże się z

lokalnym podgrzewaniem próbki, obawiano się, że może prowadzić do zmian

struktury kserożelu. Testy napylania węglem, platyną, złotem i palladem

wykazały jednak, że napylanie nie wpływa na morfologię kserożelu.

Jednocześnie udało się zauważyć, że struktura niektórych kserożeli

zależała od objętości próbki, a nawet od kształtu naczynia z próbką.

Kserożele przygotowane w standardowej butelce zawierały więcej struktur

krystalicznych niż próbki o dziesięciokrotnie mniejszej objętości

umieszczone w kapilarach. Zaobserwowano także, że przemianę amorficznych

nitek gotowego kserożelu w formę krystaliczną można przyspieszyć lekko

podgrzewając próbkę. Co więcej, niektóre kserożele zaczynały samoistnie

krystalizować po upływie kilku miesięcy. Oznacza to, że nawet poprawnie

przygotowana próbka kserożelu nim trafi pod mikroskop SEM może w istotny

sposób zmienić swoją strukturę.

"Kserożele nie grają z naukowcami czysto - przynajmniej niektóre

próbują nas oszukiwać. Teraz, gdy o tym wiemy, będziemy mogli uniknąć

wielu błędów interpretacyjnych i szybciej rozwiązać zagadkę, w jaki

sposób jedna mała cząsteczka czynnika żelującego potrafi skutecznie

związać nawet dziesięć tysięcy cząsteczek rozpuszczalnika", mówi dr

Luboradzki. | | |

Astronomia

Zwyczaje żywieniowe młodych galaktyk (21-03-2012) | Nowe obserwacje wykonane Bardzo Dużym Teleskopem (VLT) wniosły wielki wkład w zrozumienie wzrostu młodocianych galaktyk. Dzięki największemu przeglądzowi tego rodzaju astronomowie odkryli, że galaktyki zmieniły nawyki żywieniowe w swoich młodych latach - w okresie pomiędzy 3 a 5 miliardami lat po Wielkim Wybuchu. Na początku tej fazy wyrównany strumień gazu był preferowaną przekąską, jednak później rosły głównie dzięki kanibalizmowi innych, mniejszych galaktyk.

Od pewnego czasu astronomowie wiedzą, że najwcześniejsze galaktyki były mniejsze niż imponujące galaktyki spiralne i eliptyczne, które obecnie wypełniają Wszechświat. W ciągu czasu życia kosmosu galaktyki znacznie przybrały na wadze, ale ich pożywienie i zwyczaje żywieniowe ciągle pozostają zagadkowe. Nowy przegląd starannie wybranych galaktyk skupił się na młodych latach tych obiektów - w przybliżeniu w okresie od 3 do 5 miliardów lat po Wielkim Wybuchu.

Korzystając z najnowocześniejszych instrumentów na Bardzo Dużym Teleskopie (VLT) międzynarodowy zespół odkrył co się naprawdę wydarzyło. W ciągu ponad 100 godzin obserwacji zespół zebrał największy w historii zestaw dokładnych obserwacji galaktyk bogatych w gaz we wczesnych stadiach ich ewolucji.

"Rywalizują ze sobą dwie różne drogi wzrostu galaktyk: gwałtowne kolizje, w których większe galaktyki pożerają mniejsze (mergery galaktyczne), albo bardziej płynne i stałe przepływ gazu pomiędzy galaktykami. Oba rodzaje mogą prowadzić do uformowania się wielu nowych gwiazd." wyjaśnia Thierry Contini (IRAP, Tuluza, Francja), który kierował pracami.

Nowe wyniki wskazują na dużą zmianę w trakcie kosmicznej ewolucji galaktyk, gdy Wszechświat miał od 3 do 5 miliardów lat. Gładkie przepływy gazu wydają się być głównym czynnikiem w budowaniu galaktyk w bardzo młodym Wszechświecie, podczas gdy mergery stały się istotne w późniejszym okresie.

To głębokie zdjęcie niewielkiego obszaru nieba w gwiazdozbiorze Wieloryba pokazuje wybrane galaktyki (oznaczone czerwonymi krzyżykami), które zostały użyte w nowym przeglądzie dotyczącym zwyczajów żywieniowych młodych galaktyk w trakcie ich wzrostu w kosmicznej skali czasu. Każda z niewielkich plamek - galaktyk widocznych w stanie takim, jaki miały pomiędzy trzema, a pięcioma miliardami lat po Wielkim Wybuchu, została szczegółowo zbadana za pomocą należącego do ESO teleskopu VLT oraz instrumentu SINFONI. Źródło: ESO/CFHT

"Aby zrozumieć w jaki sposób galaktyki rosną i ewoluują musimy spojrzeć na nie w najdokładniejszych szczegółach. Instrument SINFONI na VLT jest jednym z najpotężniejszych narzędzi na świecie do wnikliwej analizy młodych i odległych galaktyk. Odgrywa podobną rolę, jak mikroskop dla biologów." dodaje Thierry Contini.

Odległe galaktyki, takie jak obserwowane w opisywanym przeglądzie, są małymi, słabymi plamkami na niebie, ale wysoka jakość obrazu z VLT, wspólnie z instrumentem SINFONI, oznacza, że astronomowie mogą wykonać mapy tego w jaki sposób poruszają się różne części galaktyk i z czego są stworzone. Pojawiło się kilka niespodzianek.

"Największą niespodzianką dla mnie było odkrycie wielu galaktyk, w których nie następuje rotacja ich gazu. Takich galaktyk nie obserwujemy w pobliskim Wszechświecie. Żadna z obecnych teorii nie przewiduje istnienia takich obiektów" mówi Benoît Epinat, członek zespołu.

"Nie spodziewaliśmy się także, że tak wiele młodych galaktyk w przeglądzie będzie mieć cięższe pierwiastki skoncentrowane w swoich zewnętrznych częściach - to dokładne przeciwieństwo tego co obecnie obserwujemy w galaktykach" dodaje Thierry Contini.

Zespół badawczy dopiero zaczyna eksplorować swój bogaty zestaw danych obserwacyjnych. Naukowcy planują obserwować galaktyki także za pomocą przyszłych instrumentów na VLT oraz korzystając z sieci ALMA do zbadania chłodnego gazu w tych galaktykach. Patrząc dalej w przyszłość, Ogromnie Wielki Teleskop Europejski (E-ELT) będzie idealnym urządzeniem do rozszerzenia tego typu badań na jeszcze wcześniejszy Wszechświat.

Źródło: ESO/eso1212pl | | |

Ekologia

Niemieckie wilki zdecydowanie preferują dziczyznę (21-03-2012) | Mimo ponownego pojawienia się wilków w Niemczech, lokalni rolnicy nie muszą się martwić, że zaatakują one i zjedzą ich żywy inwentarz. Wyniki badań pokazują, że w menu wilków znajduje się mniej niż 1% zwierząt gospodarskich. Badania, których wyniki zaprezentowano w czasopiśmie Mammalian Biology, podkreślają, że wilki nie zaryzykują konfrontacji z psami stróżującymi ani z niebezpiecznymi przedmiotami, żeby zdobyć pożywienie.

Zoologowie z Instytutu Badawczego Senckenberg w Görlitz w Niemczech analizowali nawyki żywieniowe wilków przez pierwszych osiem lat po ich ponownym pojawieniu się. Zespół badał zarówno co wilki obecnie jedzą, jak i sposób, w jaki ich nawyki żywieniowe zmieniały się z biegiem lat. Uzyskane wyniki wskazują na wysoką zdolność adaptacyjną wilków w celu zaspokojenia swoich potrzeb żywieniowych.

Wilki zostały wytrzebione w Niemczech na wiele lat. Teraz jednak pomału powracają.

"Nawyki żywieniowe wilków były największym punktem sporu w momencie ich powrotu do Niemiec, co skłoniło nas do szczegółowego przeanalizowania tych nawyków u wilków, które przybyły ponad 10 lat temu na Łużyce" - mówi Hermann Ansorge, kierownik Wydziału Zoologii Muzeum Historii Naturalnej Senckenberg w Görlitz. "Przyjrzeliśmy się menu wilków i temu, jak się ono zmieniało od ich pojawienia się we Wschodnich Niemczech."

Zespół zebrał i przeanalizował ponad 3.000 próbek odchodów wilków, aby znaleźć nie strawione pozostałości żeru, w tym kości, sierść, kopyta i zęby. Dane pokazują, że dzikie zwierzęta kopytne stanowią ponad 96% żeru wilków, z czego większość to sarny (55,3%), następnie jelenie europejskie (20,8%) i dziki (17,7%). Niemal 3% żeru stanowią zające.

Mniej niż 1% analizowanego żeru to inwentarz żywy, twierdzi Ansorge, dodając: "Tak długo jak owce i inne zwierzęta gospodarskie są dobrze chronione i utrzymuje się wystarczająca liczebność dzikich zwierząt, wilki nie zaryzykują konfrontacji z ogrodzeniami elektrycznymi i psami stróżującymi. Chcieliśmy dowiedzieć się, w jaki sposób, dlaczego i jak szybko skład diety wilków w Saksonii uległ zmianie."

Wilki przywędrowały do Niemiec z Polski, gdzie żywiły się głównie jeleniami europejskimi. W pierwszym roku badań naukowcy odkryli znacząco wyższy odsetek żerowania na jeleniach europejskich niż na sarnach.

"Zastanawialiśmy się, dlaczego wilki zmieniły swoje nawyki, czy też może początkowe warunki uległy zmianie" - mówi dr Ansorge. W porównaniu z polskimi lasami, te łużyckie są mniejsze i poprzecinane drogami i polami. To oznacza, że jest więcej przestrzeni życiowej dla saren i dzików, podczas gdy jelenie zwykle wycofują się do przestronniejszych obszarów leśnych. Zdaniem naukowców sarny są łatwym i obfitym żerem z perspektywy wilków.

To warunki środowiskowe wywołały zmiany w schematach żywieniowych wilków - sugerują naukowcy. Wilki szybko się przystosowały, potrzebując mniej niż dwóch pokoleń do przyzwyczajenia się do nowych warunków swojego nowego siedliska. Obecnie 9 sfor wilków z około 34 młodymi zamieszkuje na Łużycach. "Prawdopodobieństwo konfliktu między człowiekiem a wilkiem jest bardzo niskie" - stwierdza dr Ansorge. "Naprawdę nic nie stoi na przeszkodzie powrotowi wilków."

© Unia Europejska, 1994-2012

Źródło: CORDIS

Referencje dokumentu: Wagner, C., et al., 'Wolf (Canis lupus) feeding habits during the first eight years of its occurrence in Germany', Mammal. Biol., 2012. doi:10.1016/j.mambio.2011.12.004 | | |

Medycyna

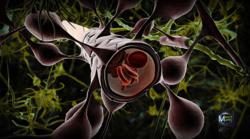

Rozwój zarodka w centrum uwagi (21-03-2012) | Naukowcy z Wlk. Brytanii zidentyfikowali ważny proces na wczesnym etapie rozwoju zarodka. Opracowali narzędzie, które jest w stanie naśladować tkankę miękką macicy ssaków, w której następuje implantacja zarodka. Wyniki mogą pomóc w opracowaniu nowych metod leczenia różnych chorób. Badania, których wyniki zaprezentowano w czasopiśmie Nature Communications, zostały częściowo dofinansowane z projektu MASC (Materiały narzucające architekturę w populacji komórek macierzystych), który otrzymał grant Europejskiej Rady ds. Badań Naukowych (ERBN) o wartości niemal 2,3 mln EUR z budżetu Siódmego Programu Ramowego (7PR) UE.

Przełomowe prace, prowadzone pod kierunkiem profesora Kevina Shakesheffa z wydziału Uwalniania Leków i Inżynierii Tkanek Uniwersytetu w Nottingham, umożliwiają przyjrzenie się nigdy wcześniej nie oglądanym aspektom rozwoju zarodkowego. Zespół obserwował w czasie rzeczywistym procesy rozwoju na decydującym etapie między czwartym a ósmym dniem rozwoju.

"Dzięki wykorzystaniu naszych unikatowych materiałów i technik, jesteśmy w stanie zaoferować naszym kolegom naukowcom nieoglądany dotąd widok niezwykłego zachowania komórek na tym decydującym etapie rozwoju zarodka" - mówi profesor Shakesheff. "Ufamy, że nasze prace rozwiążą dalsze zagadki, co mogłyby udoskonalić terapie medyczne wymagające tkanek do regeneracji, a także otworzyć więcej możliwości dla rozwoju technik zapłodnienia in vitro (IVF). W przyszłości mamy nadzieję opracować więcej technologii umożliwiających biologom rozwojowym poznawanie procesu powstawania tkanek."

Wcześniej naukowcy hodowali zapłodnione jajeczko przez cztery dni. W tym okresie rozwijało się ono z pojedynczej komórki w blastocystę. Ale nie wiadomo było, co następuje po tym etapie... aż do dzisiaj. W toku badań zespół monitorował i rejestrował nowe aspekty rozwoju zarodka po upływie czterech dni. Naukowcy zaobserwowali pierwszy krok w formowaniu się głowy, co wiązało się z przemieszczeniem się komórek pionierskich na dużą odległość w zarodku. Zidentyfikowali skupiska komórek pozazarodkowych, które sygnalizują, gdzie powinna powstać głowa zarodka.

Ustalili też, w jaki sposób komórki pojawiają się z jednej lub dwóch komórek na etapie blastocysty przed migracją do miejsca, z którego sygnalizują rozwój głowy.

"Każdy, kto czyta ten artykuł, rozwinął się z pojedynczej komórki" - mówi profesor Shakesheff. "W ciągu kilku tygodni od zawiązania się zarodka wszystkie najważniejsze tkanki i organy są ukształtowane i zaczynają funkcjonować. Jeżeli bylibyśmy w stanie okiełznać tę niezwykłą zdolność organizmu ludzkiego do samokształtowania się, moglibyśmy opracować nowe terapie medyczne do leczenia chorób na dzień dzisiejszy nieuleczalnych. Na przykład choroby i wady serca mogłyby stać się odwracalne, jeżeli bylibyśmy w stanie odtworzyć proces powstawania mięśnia sercowego i podłączyć się do układu krwionośnego i nerwowego."

© Unia Europejska, 1994-2012

Źródło: CORDIS

Referencje dokumentu: Morris, S.A., et al. (2012) 'Dynamics of anterior-posterior axis formation in the developing mouse embryo', Nature Communications, 3: 673. doi: 10.1038/ncomms1671 | | |

Zdrowie

Legalna aborcja bezpieczniejsza niż poród (19-03-2012) | Ryzyko zdrowotne związane z przerwaniem ciąży to jeden z argumentów wysuwanych niekiedy w dyskusjach na temat legalnej aborcji, zwłaszcza w krajach, w których dostęp do tej procedury medycznej jest łatwiejszy niż w Polsce. Elizabeth G. Raymond i David A. Grimes, lekarze od lat zajmujący się kwestiami zarówno ginekologii i położnictwa, jak i zdrowia publicznego, postanowili ocenić na ile rzeczywiste są czyhające na poddające się temu zabiegowi kobiety niebezpieczeństwa - wszak polityka zdrowotna powinna opierać się na możliwie najlepszym i najbardziej aktualnym materiale dowodowym.

Liczbę zgonów i poważnych zaburzeń zdrowotnych związanych z legalnymi zabiegami przerwania ciąży porównano z liczbą tychże wikłających porody (pominięto naturalne poronienia, ciąże zaśniadowe czy ciąże pozamaciczne, by nie zawyżać statystyk ryzyka ciążowego), opierając się na danych zebranych przez CDC (Centers for Disease Control and Prevention's Pregnancy Mortality Surveillance System) oraz danych epidemiologicznych uzyskanych z placówek zdrowotnych oferujących usługę legalnego przerwania ciąży. Zebrano także dane z wszystkich odbywających się w badanym okresie badań populacyjnych dotyczących umieralności okołoporodowej i poaborcyjnej.

| | 1. Embrion po całkowicie samoistnym poronieniu w ok. 6. tygodniu od poczęcia, Wikipedia |

Badanie objęło dane z okresu 1998-2005. Był to czas, w którym nastąpiło kilka znaczących zmian dotyczących problematyki ciąży i aborcji. W roku 2000 FDA zaaprobowała mifepriston (RU-486) do użytku medycznego, co spowodowało rosnącą częstość aborcji farmakologicznej i tendencję spadkową chirurgicznych zabiegów przerwania ciąży. Jednocześnie zaczął się zmieniać profil populacyjny ciężarnych - rosnący odsetek kobiet z nadwagą, coraz wyższy wiek pierworódek, etc wpływają też na zmiany ryzyka zdrowotnego ciąży i porodu. Tego typu zmiany zawsze wymagają aktualizacji danych epidemiologicznych.

Na przestrzeni omawianych 7 lat umieralność ciężarnych wynosiła 8,8 zgonów na 100 000 żywych urodzeń, przy czym stanowi to zaledwie 71% zgonów okołociążowych - uwzględnienie dodatkowo odpowiednio 71% przypadków, gdy nie było dostępnych danych o stanie noworodka (urodzenia żywe lub martwe), podniosłoby tę liczbę do 10,4 zgonów na 100 000. W tym samym okresie umieralność związana z legalnymi, wykonywanymi pod kontrolą lekarską zabiegami przerwania ciąży wynosiła zaledwie 0,6 zgonów na 100 000 aborcji, z czego wypływa wniosek, iż donoszenie ciąży wiąże się z 14.7-krotnym wzrostem ryzyka zgonu dla żywych urodzeń (i 17.3-krotnym przy uwzględnieniu danych z ciąż o nieznanym statusie rozwiązania).

Ocena innych konsekwencji zdrowotnych przerwania tudzież donoszenia ciąży była nieco trudniejsza ze względu na ograniczoną dostępność danych. Tu autorzy oparli się głównie na opublikowanym wcześniej przez epidemiologów z CDC raporcie z lat 1998-2001 obejmującym dane na temat 24 481 ciąż, spośród których 16 824 zakończyło się żywymi urodzeniami, 4192 zaś legalnymi indukowanymi poronieniami. Zaburzenia zdrowotne bezpośrednio wywołane ciążą bądź przez ciążę zaostrzone wystąpiły w ok. 5% przypadków. Każda z uwzględnionych komplikacji (niedokrwistość, zaburzenia natury psychicznej, nadciśnienie, infekcje, etc) występowała znacząco częściej w populacji, która donosiła ciążę niż w populacji, która decydowała się na aborcję.

Dane zebrane przez Raymond i Grimesa jednoznacznie wskazują, że - jeśli wziąć pod uwagę jedynie zdrowie ciężarnej - legalna, kontrolowana medycznie aborcja jest bezpieczniejszym dla kobiety rozwiązaniem. Nie jest to wynik dziwny w obliczu rosnącej w stosunku do aborcji chirurgicznej proporcji procedur przerwania ciąży wykorzystujących jedynie metody farmakologiczne. Nie dziwi też mniejsza liczba innych niż zgon powikłań zdrowotnych związanych ze sztucznymi poronieniami - ciąża nie jest stanem obojętnym dla organizmu, a jej przerwanie zazwyczaj znacząco skraca czas narażenia na zmiany hormonalne i ich konsekwencje, praktycznie wykluczając te z nich, które charakterystyczne są dla ciąży późnej.

Źródło: The comparative safety of legal induced abortion and childbirth in the United States., Raymond EG, Grimes DA; Obstetrics & Gynecology, vol. 119, no. 2, part 1, 2012, pp 215-9. Abstrakt

Komentarz do badania: Abortion, Pregnancy, and Public Health, Mitchell D. Creinin; Obstetrics & Gynecology, vol. 119, no. 2, part 1, 2012, pp 212-14. | | |

Astronomia

Astronomowie znaleźli dowody na istnienie życia we Wszechświecie (17-03-2012) | Dzięki obserwacjom Księżyca za pomocą Bardzo Dużego Teleskopu (VLT), należącego do ESO, astronomowie znaleźli dowody na istnienie życia we Wszechświecie - na Ziemi. Poszukiwanie życia na naszej rodzinnej planecie może wydawać się trywialnym zadaniem, ale nowatorskie podejście międzynarodowego zespołu naukowców może w przyszłości doprowadzić od odkrycia życia w innym miejscu Wszechświata. Wyniki badań zostały opisane w artykule, który ukazał się 1 marca 2012 r. w czasopiśmie "Nature".

"Wykorzystaliśmy sztuczkę zwaną obserwacjami światła popielatego Księżyca, aby spojrzeć na Ziemię tak jakby była planetą pozasłoneczną" mówi Michael Sterzik (ESO), główny autor publikacji. "Słońce oświetla Ziemię i jego światło jest odbijane z powrotem, trafiając na powierzchnię Księżyca. Powierzchnia Księżyca działa jak gigantyczne zwierciadło i z powrotem odbija światło docierające od Ziemi - właśnie je obserwowaliśmy za pomocą VLT".

Światło popielate można łatwo dostrzec gołym okiem, a szczególnie spektakularny widok otrzymamy przy zastosowaniu lornetki. Najlepiej widać je gdy Księżyc jest w fazie wąskiego sierpa, około trzy dni przed lub po nowiu. Poza jasnym sierpem widać wtedy poświatę na pozostałej części tarczy Księżyca, rozświetloną dzięki światłu odbitemu od Ziemi.

Astronomowie analizowali słabe światło popielate w poszukiwaniu wskaźników takich jak pewne kombinacje gazów w ziemskiej atmosferze, które mogą wskazywać na istnienie życia organicznego. Metoda ta ustanawia Ziemię jako punkt porównania dla przyszłych poszukiwać życia na planetach poza Układem Słonecznym.

Zdjęcie przedstawia sierp Księżyca nad Obserwatorium ESO Paranal w Chile. Można dostrzec zarówno jasny sierp, jak i resztę tarczy Księżyca. Zjawisko to nazywane jest światłem popielatym. Powstaje dzięki słonecznemu światłu odbitemu od Ziemi i oświetlającemu księżycową powierzchnię. Obserwując światło popielate astronomowie mogą badać własności światła odbitego od Ziemi, tak jakby była planetą pozasłoneczną i poszukiwać oznak istnienia na niej życia. Fotografia została wykonana 27 października 2011 roku. Widać na niej także planety Merkury i Wenus. Źródło:ESO/B. Tafreshi/TWAN

W ziemskiej atmosferze głównymi gazami wytworzonymi biologicznie są tlen, ozon, metan i dwutlenek węgla. Ale mogą one występować również w sposób naturalny w atmosferach planet nie posiadających życia. Tym co czyni je biologicznymi sygnaturami, jest jednoczesne występowanie gazów w odpowiednich ilościach, które można wytłumaczyć jedynie istnieniem życia. Gdyby życie nagle zniknęło i nie rozprzestrzeniało już tych gazów, Część szybko by zanikła, a wraz z nią charakterystyczne sygnatury biologiczne.

Wskaźniki życia, albo sygnatury biologiczne, są trudne do wykrycia konwencjonalnymi metodami, ale zespół zastosował nowatorskie podejście, które jest bardziej czułe. Zamiast analizować jak jasne jest odbite światło w poszczególnych barwach, naukowcy zbadali za pomocą VLT polaryzację światła. Technika ta zwana jest spektropolarymetrią. Sygnatury biologiczne w odbitym świetle ukazały się bardzo wyraźnie po jej zastosowaniu do światła popielatego Księżyca obserwowanego teleskopem VLT.

Stefano Bagnulo (Armagh Observatory, Irlandia Północna, Wielka Brytania), współautor pracy, wyjaśnia uzyskane korzyści: "Światło od odległej egzoplanety jest ukryte w blasku jego gwiazdy centralnej, przez co bardzo trudno się je analizuje - to tak jakby próbować zbadać ziarenko pyłu umieszczone obok silnej żarówki. Ale światło odbite przez planetę jest spolaryzowane, natomiast światło od gwiazdy - nie. Zatem techniki polarymetryczne pomagają nam w rozróżnieniu słabego światła odbitego przez egzoplanetę od oślepiającego światła gwiazdy".

Zespół naukowców zbadał zarówno kolor, jak i stopień polaryzacji światła pochodzącego od Ziemi, po jego odbiciu od Księżyca, tak jakby pochodziło od planety pozasłonecznej. Udało się wydedukować, że ziemska atmosfera jest częściowo zachmurzona, że część powierzchni planety jest pokryta oceanami oraz - co najważniejsze - że istnieje na niej roślinność. Można było nawet wykryć zmiany w pokrywie chmur i ilości roślinności, gdy w różnym czasie różne obszary Ziemi odbijały światło w kierunku Księżyca.

Gdy światło jest spolaryzowane, jego składowe pól elektrycznego i magnetycznego mają określoną orientację. W niespolaryzowanym świetle orientacja pól jest losowa i nie ma preferowanego kierunku. W niektórych kinach 3D stosuje się właśnie polaryzację światła: osobne obrazy wytworzone różnie spolaryzowanym światłem są za pomocą filtrów polaryzacyjnych w okularach przesyłane do naszego lewego i prawego oka. Zespół zmierzył polaryzację korzystając ze specjalnego trybu obserwacji instrumentu FORS na VLT.

"Poszukiwania życia poza Układem Słonecznym zależą od dwóch czynników: po pierwsze, czy takie życie w ogóle istnieje, a po drugie, czy posiadamy techniczne możliwości jego wykrycia" dodaje współautor Enric Palle (Instituto de Astrofisica de Canarias, Teneryfa, Hiszpania). "Nasza praca jest ważnym krokiem w kierunku uzyskania takich możliwości."

"Spektropolarymetria może ostatecznie powiedzieć nam czy proste życie roślinne - oparte o procesy fotosyntezy - powstało gdzieś we Wszechświecie" podsumowuje Sterzik. "Na pewno jednak nie szukamy małych zielonych ludzików lub dowodów na życie inteligentne".

Następna generacja teleskopów, takich jak E-ELT (Ogromnie Wielki Teleskop Europejski), może być w stanie dostarczyć nadzwyczajną wiadomość, że Ziemia nie jest jedynym siedliskiem życia w ogromnej przestrzeni kosmosu.

Skład zespołu badawczego: Michael F. Sterzik (ESO, Chile), Stefano Bagnulo (Armagh Observatory, Irlandia Północna, Wielka Brytania) oraz Enric Palle (Instituto de Astrofisica de Canarias, Teneryfa, Hiszpania).

Źródło: ESO

Referencje dokumentu: M. Sterzik et al., "Biosignatures as revealed by spectropolarimetry of Earthshine", Nature 483, 64-66 (01 March 2012) doi:10.1038/nature10778 | | |

Technika

Przełomowe, bezwodne metody wytwarzania mikroukładów (17-03-2012) | Maleńkie, bardzo szybkie mikroukłady, stosowane w każdym współczesnym urządzeniu elektronicznym, znacznie się różnią od swoich dużych, powolnych przodków sprzed kilku dekad. Dzięki nowym materiałom, architekturom oraz technikom produkcji kolejne generacje układów scalonych mają coraz większą wydajność oraz coraz niższą cenę. Przełomowe, finansowane ze środków UE badania naukowe pomagają podtrzymać powyższy trend...

Prawo Moore'a - czyli spostrzeżenie dokonane przez współzałożyciela firmy Intel, Gordona E. Moore'a, w myśl którego liczba tranzystorów w układzie scalonym, a tym samym moc obliczeniowa, podwaja się co mniej więcej dwa lata - okazało się prawdziwe przez ponad pół wieku. Obecnie używane przez nas telefony komórkowe mają większą moc obliczeniową, niż kikla dekad temu miały komputery o wielkości domu. Jednak aby na coraz mniejszej przestrzeni zmieścić coraz więcej tranzystorów - i podtrzymać prawdziwość prawa Moore'a - twórcy mikroukładów muszą być coraz bardziej innowacyjni, gdyż komponenty tworzące mikroukład powoli kurczą się do rozmiarów mierzonych w "nano" skali.

Czasami projektanci układów muszą myśleć w bardzo nieszablonowy sposób. Takie nieszablonowe podejście obrano na przykład w ramach projektu ("Wydajność i niezawodność dzięki złączom miedzianym" - 'Copper interconnects for advanced performance and reliability' (Copper), którego uczestnicy, będący członkami ośmiu organizacji - firm, instytów badawczych oraz uniwersytetów - z czterech krajów rozwiązali kluczowe wyzwanie z dziedziny wytwarzania mikroukładłów. Naukowcy Ci otworzyli także wrota całkowicie nowej dziedziny badań naukowych w przemyśle półprzewodnikowym.

Badacze, przy wsparciu ze strony Komisji Europejskiej w kwocie 3,15 milionów euro, skupili się na metodach i materiałach używanych do łączenia ze sobą maleńkich tranzystorów w obrębie współczesnego mikroukładu. Uczestnicy projektu Copper opracowali proces, który pozwala stosować metale reaktywne jako barierę pomiędzy złączami miedzianymi a płytką krzemową mikroukładu, dzięki użyciu rozpuszczalników niewodnych zamiast rozpuszczalników wodnych - co jest nowością w przemyśle półprzewodnikowym.

"Wraz ze wzrostem liczby tranzystorów tworzących mikroukład wzrasta długości łączy pomiędzy tymi tranzystorami. Ponieważ złącza charakteryzują się pewną rezystancją wzrost ich długości może powodować opóźnienia w komunikacji pomiędzy tranzystorami, a tym samym spadek szybkości działania mikroukładu", tłumaczy Jan Fransaer, naukowiec pracujący w Katedrze Metalurgii i Inżynierii Materiałowej ('Department of Metallurgy and Materials Engineering' - MTM) Katolickiego Uniwersytetu w Leuven, w Belgii.

Zmniejszenie rozmiaru złączy pozwala zwiększyć wydajność mikroukładu. Jednak obecnie podzespoły tworzące mikroukłady wytwarzane są w skali 22nm - około 3 000 mniejszej, niż grubość ludzkiego włosa - z czym wiąże się szereg przeszkód stojących na drodze do dalszego zmniejszania rozmiarów połączeń.

Do połowy lat 90-tych do wypełniania "rynienek" tworzących złącza, czyli niewielkich ścieżek przez które pomiędzy tranzystorami przemieszczają się elektrony, używano aluminium. Aluminium posiada wystarczającą przewodność właściwą, pozwalającą sprostać potrzebom tranzystorów, których wówczas w jednym mikroukładzie było kilka milionów, a w przeciwieństwie do innych metali przewodzących, takich jak miedź, srebro i złoto, nie przenika do krzemu, co mogłoby powodować zniszczenie obwodów.

Jednak wraz z postępującą miniaturyzacją i zwiększaniem się liczby tranzystorów do miliardów, niezbędne było opracowanie szybszych złączy. To wymagało zastosowania materiału o większej przewodności właściwej. Producenci półprzewodników zaczęli więc wytwarzać złącza przy użyciu miedzi. Niezbędne było zapobieżenie przenikaniu miedzi do krzemu, co osiągnięto dzięki tzw. "barierze dyfuzyjnej" (warstwie innego metalu, który chroni krzem przed działaniem miedzi). Najczęściej do produkcji bariery dyfuzyjnej stosuje się tantal.

Jak na razie rozwiązanie się sprawdza: bariera dyfuzyjna z tantalu chroni krzem przed działaniem miedzi użytej do produkcji ścieżek stanowiących złącza.

Ścieżki te wytwarza się w procesie zwanym osadzaniem elektrolitycznym, w którym prąd płynący przez roztwór rozpuszczalnika powoduje osadzanie się jonów metalu na ścieżkach. Zwykle jako roztworu używa się rozpuszczalnika wodnego.

Jest jednak pewien problem: tantal ulega natychmiastowemu utlenieniu w kontakcie z wodą, zatem jak dotychczas producenci musieli najpierw pokryć tantalową barierę dyfuzyjną miedzią, w celu stworzenia warstwy chroniącej tantal przed działaniem wody, podobnie jak ma to miejsce w przypadku warstwy tantalu chroniącej krzem przed działaniem miedzi.

Ochronną warstwę miedzi wytwarza się w procesie zwanym "osadzaniem chemicznym z fazy gazowej" ('chemical vapour deposition' - CVD).

"Dlaczego jednak nie można po prostu wykorzystać warstwy miedzi jako do tworzenia połączeń? Gdyż CVD jest specyficznym procesem: pozwala on osadzać warstwę miedzi o grubości wystarczającej do ochrony znajdującego się pod nią tantalu, jednak zbyt cienką, by tworzyć w niej nieprzerwane połączenia. W związku z tym niezbędne jest osadzenie elektrolityczne, przeprowadzane na ochronnej warstwie miedzi, które pozwala wypełnić "rynienki" wystarczająco grubą warstwą miedzi, by stworzyć połączenia", tłumaczy prof. Fransaer.

Można powiedzieć, że producenci mikroukładów bawią się "rosyjskimi matrioszkami" w skali nanometrowej.

"To, że rozwiązując jeden problem powodujemy pojawienie się innego może wydawać się głupie, jednak powyższe rozwiązanie jak do tej pory dobrze się sprawdzało", zauważa prof. Fransaer.

Co zatem się zmieniło? Skala. Ochronna warstwa miedzi ma grubość od 5 nm do 10 nm, zatem jeśli skala wynosi mniej niż 22 nm warstwa ta, której celem jest tylko i wyłącznie ochrona tantalowej bariery dyfuzyjnej przed utlenieniem podczas wytwarzania mikroukładu, zaczyna zajmować o wiele za dużo miejsca.

Zamiast używać wody uczestnicy projektu Copper opracowali innowacyjny proces, w którym stosuje się rozpuszczalniki niewodne, np. płynny amoniak oraz płyny jonowe. Ciecze te nie powodują utleniania tantalu, a zatem umożliwiają przeprowadzenie osadzania elektrolitycznego bez użycia miedzianej warstwy ochronnej. W efekcie, dzięki temu, że ścieżki połączeniowe mogą być mniejsze, możliwe jest zmniejszenie rozmiaru mikroukładu, zwiększenie liczby tranzystorów oraz drastyczne zwiększenie wydajności mikroukładu.

"Osadzanie elektrolityczne przy użyciu płynnego amoniaku lub płynów jonowych przeprowadzano już wcześniej, jednak my po raz pierwszy zastosowaliśmy je w przemyśle półprzewodnikowym", mówi prof. Fransaer. "Technika ta z pewnością pomoże zapewnić ciągłość prawa Moore'a przez co najmniej kilka najbliższych dekad".

By opracować powyższy proces członkowie zespołu projektowego przeanalizowali różne materiały służące do produkcji płytek oraz elektrolityczne składniki rozpuszczalników niewodnych, zbadali ich właściwości fizyczne oraz zastosowali techniki analityczne i symulacyjne, w celu obrania możliwie najlepszego podejścia. Następnie naukowcy przeprowadzili mikro-modelowanie procesu, przed stworzeniem prototypu będącego dowodem słuszności ich pomysłów.

"Poruszaliśmy się na całkowicie niezbadanym obszarze. Przed rozpoczęciem projektu Copper nie opublikowano ani jednego artykułu dotyczącego stosowania niewodnych roztworów w przemyśle półprzewodnikowym", zauważa kierownik projektu.

Nie dziwi zatem, że projekt spotkał się z dużym zainteresowaniem ze strony producentów mikroukładów, w momencie, gdy jego uczestnicy zaczęli prezentować uzyskane wyniki podczas międzynarodowych konferencji.

"Zainteresowanie było z pewnością duże, jednak nie jesteśmy w stanie stwierdzić z całą pewnością, czy ktokolwiek wykorzystał nasze badania jako podstawę komercyjnego zastosowania tego procesu. Mimo to uważam, że teraz, gdy już pokazaliśmy, że możliwe jest stosowanie roztworów niewodnych, ich komercyjne wykorzystanie jest tylko kwestią czasu", mówi prof. Fransaer.

Chociaż amoniak, który w formie ciekłej występuje jedynie pod ciśnieniem, czy płyny jonowe są mniej dostępne i droższe niż woda, koszt ich stosowania nie stanowi problemu w przemyśle półprzewodnikowym, którego obroty sięgają wielu miliardów euro, zauważa prof. Fransaer.

"Zastąpienie roztworów wodnych niewodnymi miałoby, w kontekście globalnym, bardzo niewielki wpływ na koszty", mówi prof. Fransaer.

Co być może bardziej istotne, badania przeprowadzone przez uczestników projektu pozwoliły uświadomić ludziom, że istnieje wiele możliwości i dotyczą one nie tylko tantalu, ale także innych metali i nie tylko zastosowań półprzewodnikowych.

Przykładowo, członkowie konsorcjum projektowego planują kontynuować swe prace, w ramach projektu bazującego na wynikach projektu Copper, w celu ulepszenia sposobów rozpraszania ciepła w elektronice energetycznej, która będzie niezbędnym elementem inteligentnych sieci elektrycznych, które obecnie pojawiają się w Europie i poza nią.

"Wiele pierwiastków, wśród nich tak zwane materiały szlachetne, można galwanizować przy użyciu wody, jednak w przypadku niektórych z nich nie jest to możliwe. Dotyczy to np.: aluminium, krzemu, germanu itd. Wykazaliśmy, że roztwory niewodne umożliwiają galwanizowanie niektórych z tych materiałów. Otwiera to wrota do szeregu całkowicie nowych zastosowań, które wcześniej prawdopodobnie nie wydawały się nawet możliwe", twierdzi prof. Fransaer.

Projekt Copper uzyskał wsparcie finansowe ze strony Komisji Europejskiej w ramach (Siódmego Programu Ramowego UE - 7PR).

© Unia Europejska, 1994-2012

Źródło: CORDIS

Na podstawie informacji uzyskanej od prof. Jana Fransaera, Katedra Metalurgii i Inżynierii Materiałowej ('Department of Metallurgy and Materials Engineering' - MTM) Katolickiego Uniwersytetu w Leuven, Belgia. | | |

Zdrowie

Unijni naukowcy analizują wagę noworodków (16-03-2012) | Kiedy w organizmie kobiety ciężarnej występuje podwyższony poziom polichlorowanych bifenyli (PCB), jej nowo narodzone dzieci będą prawdopodobnie miały niedowagę. Odkrycie to stanowi dorobek badań finansowanych ze środków unijnych, których wyniki zostały opublikowane w czasopiśmie Environmental Health Perspectives.

Naukowcy z Belgii, Danii, Finlandii, Francji, Grecji, Hiszpanii, Holandii, Niemiec, Norwegii, Słowacji i Wysp Owczych otrzymali wsparcie finansowe z dwóch projektów dofinansowanych z budżetu Siódmego Programu Ramowego (7PR) UE. Zespół objął badaniami 8.000 kobiet ciężarnych, których porody przypadły na lata 1990 - 2008 w całej Europie i poddał je kontroli pod kątem stężenia PCB we krwi.

Naukowcy przeanalizowali próbki mleka matek i krwi pobranych od matek i/lub z pępowiny, aby przetestować je na obecność kongenera 153 PCB oraz dichlorodifenylodichloroetylenu (DDE), który jest produktem uwalnianym w wyniku rozkładu dichlorodifenylotrichloroetanu (DDT). Następnie porównano uzyskane wyniki z wagą noworodków.

Badania uzyskały wsparcie na kwotę niemal 1 mln EUR z projektu ENRIECO (Zagrożenia środowiskowe dla zdrowia w europejskich kohortach urodzeniowych) oraz na kwotę niemal 3 mln EUR z projektu OBELIX (Sprzyjające otyłości środki chemiczne zakłócające wydzielanie wewnętrzne - związek prenatalnej ekspozycji z otyłością w późniejszym okresie życia). Projekty otrzymały środki odpowiednio z tematów "Środowisko" i "Żywność, rolnictwo, rybołówstwo i biotechnologia" 7PR.

Zakazane w większości krajów od kilku dekad ze względu na swoją toksyczność i zaklasyfikowanie do trwałych, organicznych substancji zanieczyszczających, PCB wykorzystywano wcześniej jako dielektryki i chłodziwa na przykład w transformatorach, kondensatorach i silnikach elektrycznych. Mimo to, z powodu swojej wysokiej stabilności i zdolności do gromadzenia się w tkance tłuszczowej ludzi i zwierząt, nadal są obecne w środowisku. W przypadku ludzi głównym źródłem PCB jest spożywanie tłustych ryb, ale są też i inne źródła. Nadal nie wiadomo, jaki wpływ mają niewielkie dawki na kobiety ciężarne.

Wyniki wskazują na wyraźne powiązanie stężenia PCB z wagą noworodka. Matki, u których stężenie PCB w krwi pępowinowej wyniosło 1 mikrogram na litr rodziły dzieci lżejsze o 150 g od dzieci matek z niewykrywalnym stężeniem we krwi. Można to porównać z paleniem tytoniu: matki palące w czasie ciąży rodziły dzieci o podobnym spadku wagi urodzeniowej. W przypadku innej badanej substancji - DDE - nie stwierdzono wpływu na wagę urodzeniową.

Naukowcy kontynuują analizę sposobu, w jaki wyższe stężenia PCB przekładają się na niższą wagę urodzeniową, gdyż możliwe jest, że PCB zakłócają równowagę hormonalną, a przez to rozwój płodu.

Badania wykazują zatem, że ograniczenie zastosowania PCB było roztropnym działaniem, a stały monitoring obcych substancji w organizmie człowieka jest nieodzowny.

Ostatecznym celem projektu ENRIECO jest pogłębienie naszej wiedzy na temat specyficznych relacji przyczynowych środowisko-zdrowie w kohortach ciążowych i urodzeniowych. Projekt wspiera wykorzystywanie bogatych zbiorów danych zgromadzonych w ramach wcześniejszych i obecnie realizowanych badań, dofinansowywanych ze środków Komisji Europejskiej i programów krajowych. Konkretne cele polegają na przygotowaniu spisów kohort urodzeniowych, zapewnieniu jakości i kompatybilności ekspozycji, danych na temat zdrowia i reakcji na ekspozycję, uzyskania dostępu do danych, budowaniu baz danych, przeprowadzaniu analiz, formułowaniu zaleceń dotyczących gromadzenia danych w przyszłości w celu przybliżenia powiązań środowisko-zdrowie i doskonalenia informacji na ich temat oraz upowszechnianiu informacji.

Projekt OBELIX koncentruje się na badaniach nad otyłością dziecięcą, która osiąga na świecie rozmiary epidemiczne. Odpowiada na pilną potrzebę pogłębienia naszej wiedzy na temat roli kontaminantów spożywczych w otyłości.

© Unia Europejska, 1994-2012

Źródło: CORDIS

Referencje dokumentu: Govarts, E., et al. (2012) Birth Weight and Prenatal Exposure to Polychlorinated Biphenyls (PCBs) and Dichlorodiphenyldichloroethylene (DDE): A Meta-analysis within 12 European Birth Cohorts. Environmental Health Perspectives. 120:162-170. | | |

Technika

Klaustrofobia w rezonansie magnetycznym – technika i psychologia (15-03-2012) |

Opinii publicznej często serwuje się elegancki obraz neuronauk jako wyrafinowanej dziedziny badań, korzystającej z rozwiązań na najwyższym poziomie technologicznego zaawansowania, w której człowiek zdaje się ogrywać rolę niepozornego dodatku do imponującej aparatury. Media - zarówno te popularne, jak i te specjalistyczne prezentują dokonania neuronauk w formie, która kojarzy się przede wszystkim z laboratoryjną sterylnością i precyzją, a czynią to w sposób tak sugestywny, że niewiele osób spoza tzw. środowiska zdaje sobie sprawę, jak uprawianie neuronauk i praktyczne wykorzystywanie ich osiągnięć tak naprawdę wyglądają od kuchni.

Kształtowaniu takiego wizerunku neuronauk sprzyja zapewne profesjonalny chłód i powściągliwość, które cechują nieprzystępny żargon fachowej literatury przedmiotu, ale również nieodmienna fascynacja mediów relacjonujących osiągnięcia naukowców i ich odbiorców klimatem high-tech. Czasami można wręcz zapomnieć, że za atrakcyjnymi obrazami - na przykład finalnymi efektami obróbki danych uzyskanych w trakcie skanowania mózgu - kryje się nie tylko żywa tkanka, ale po prostu człowiek, o którego przede wszystkim powinno tu chodzić.

Na przykład wydaje się, że dość niska jest społeczna świadomość, jak poważnym problemem towarzyszącym od początku wykorzystaniu technik neuroobrazowania zarówno do celów diagnostycznych, jak naukowo-badawczych jest klaustrofobia, czyli lęk przed przebywaniem w zamkniętej, ograniczonej przestrzeni. Zagadnienia klaustrofobii nie da się zignorować, gdy mowa między innymi o obrazowaniu metodą rezonansu magnetycznego, co z pewnością łatwo zrozumie każdy (pacjent czy osoba badana), kto musiał przebywać przez dłuższy czas w wymuszonym i nienaturalnym bezruchu w długiej i wąskiej komorze skanera, nawet z pełną świadomością, że samo badanie, przy zachowaniu pewnych minimalnych środków ostrożności, uchodzi za całkowicie bezpieczne.

Ocenia się, że nieprzyjemne, lękotwórcze doznania (ograniczenie ruchu, hałas i wibracje, obawa przed utknięciem) związane z przebywaniem w zamkniętej komorze rezonansu magnetycznego są udziałem nawet 35% osób badanych. Zdarza się, że nadmierny lęk osoby badanej, mimo zachowania empatycznego i cierpliwego podejścia personelu, wymaga wydłużenia czasu badania (lub nawet jego przerwania) lub zastosowania środków farmakologicznych o działaniu uspokajającym i przeciwlękowym (sedacja), co oznacza dodatkowe koszty i nie zawsze jest całkowicie bezpieczne.

Nic dziwnego, że zapobieganie klaustrofobii stało się prawdziwym wyzwaniem dla konstruktorów urządzeń do rezonansu magnetycznego, dzięki czemu ośrodki diagnostyczne coraz częściej korzystają z aparatów o krótkiej lub otwartej komorze.

Czy jednak zastosowanie tych urządzeń rzeczywiście istotnie zmniejsza ryzyko wystąpienia klaustrofobii? Wyniki badań prowadzonych nad tym zagadnieniem przedstawili naukowcy z Uniwersytety Medycznego Charité w Berlinie. Zostały one opublikowane online w PLoS ONE w dniu 22 sierpnia 2011.

"Klaustrofobia jest wyzwaniem powszechnie towarzyszącym przeprowadzaniu obrazowania metodą rezonansu magnetycznego, co jak dotąd stało się przedmiotem pewnej liczby nierandomizowanych badań - zauważają naukowcy. - Ustalono, że w przypadku od 1 do 15% badań rezonansem magnetycznym z udziałem dowolnej grupy pacjentów konwencjonalne badanie nie może zostać ukończone z powodu klaustrofobii lub wymaga podania leków uspokajających. Interwencje poznawczo-behawioralne, polegające na konfrontowaniu pacjenta z lękotwórczymi bodźcami, okazały się jednym ze skuteczniejszych sposobów radzenia sobie z problemem klaustrofobii. Ustrukturalizowane okazywanie empatycznego zainteresowania pacjentom ze strony specjalnie przeszkolonego personelu, a także instruowanie pacjentów w zakresie stosowania autohipnotycznych technik relaksacyjnych również okazało się dość skutecznym środkiem redukowania lęku w czasie badania rezonansem magnetycznym i przy przeprowadzaniu innych procedur medycznych. Jednakże zastosowanie powyższych rozwiązań nie zawsze jest możliwe. Dlatego inne podejście, służące obniżaniu częstości napadów klaustrofobii, polega na modyfikowaniu budowy samych skanerów. Dwa ostatnio zastosowane pomysły to otwarty panoramiczny skaner i skaner z krótką komorą. Porównaliśmy te dwa typy skanerów w randomizowanych badaniach z grupą kontrolną, z udziałem pacjentów z grupy podwyższonego ryzyka napadu klaustrofobii w czasie przeprowadzania obrazowania metodą rezonansu magnetycznego".

W badaniach wzięło udział 172 pacjentów obu płci, kierowanych na obrazowanie głowy, kręgosłupa lub obręczy barkowej metodą rezonansu magnetycznego z użyciem krótkiego lub otwartego skanera z uwagi na podwyższone ryzyko wystąpienia klaustrofobii. Ryzyko klaustrofobii oceniano na podstawie specjalnego kwestionariusza. Przeważającą część osób badanych stanowiły kobiety (80%), co zbieżne jest z wynikami badań wskazujących na niższą odporność na stres, wyższy ogólny poziom lęku i wyższą reaktywność emocjonalną kobiet w porównaniu z mężczyznami.

Dobrane w ten sposób osoby badane losowo przydzielono do badań z użyciem skanera o krótkiej komorze lub skanera otwartego. Za atak klaustrofobii uznano takie nasilenie reakcji lękowych, które uniemożliwiało dokończenie badania. Jeżeli osoba badana nie była w stanie przejść badania na jednym skanerze, po tygodniu kierowano ją na badanie drugim urządzeniem. Jeśli i to nie pomogło w redukcji symptomów lękowych, dopiero wówczas stosowano środki farmakologiczne.

Jak zauważają naukowcy, wyniki badań okazały się dość rozczarowujące, nawet biorąc pod uwagę, że osoby badane pochodziły z grupy podwyższonego ryzyka klaustrofobii.

W grupie skierowanej do badania skanerem o krótkiej komorze aż u 33 osób (39%) wystąpił atak klaustrofobii, który nie pozwolił na dokończenie badania. W przypadku zastosowania otwartego skanera ilość ataków klaustrofobii była nieco niższa, ale nadal znaczna: atak klaustrofobii wystąpił u 23 (26%) osób badanych, a średni czas badania był nieco dłuższy; z drugiej jednak strony ze względów technicznych czas potrzebny na zakończenia badania z sukcesem był istotnie krótszy w przypadku wykorzystania skanera o krótkiej komorze.

U 12 osób badanych atak klaustrofobii wystąpił już w momencie wchodzenia do gabinetu badań, a więc jeszcze zanim w ogóle zbliżyły się do urządzenia. Aż 37 ataków klaustrofobii wystąpiło w czasie zajmowania pozycji na ruchomym stole, czyli przed wjazdem do komory. W czasie samego badania, które jest - jakby się wydawało - najbardziej lękotwórcze, ze względu na długi czas trwania, ograniczenie swobody ruchów, hałas i wibracje, u badanych wystąpiły tylko 4 ataki klaustrofobii (po 2 w każdej z grup).

"Biorąc pod uwagę wyniki naszych badań, w przyszłych badaniach klinicznych należałoby się zająć skanerami MR bardziej skoncentrowanymi na pacjencie i poszukiwaniu możliwości dalszego ograniczania ryzyka klaustrofobii. Obiecujące podejście związane jest z opracowaniem przenośnego otwartego skanera MR. Jednakże niskie i niejednorodne pola magnetyczne nadal stanowią wyzwanie dla klinicznego zastosowania takich systemów. Wyniki naszych badań podkreślają, że najtrudniejszą fazą procedury badania jest zajmowanie miejsca na stole skanera, a także wejście do gabinetu badań. Dlatego modyfikacja samej procedury badania również może mieć wpływ na ograniczenie częstości ataków klaustrofobii".

Naukowcy podkreślają, że w redukcji poziomu ryzyka wystąpienia ataku klaustrofobii w trakcie badania MR przydatne mogą być obok rozwiązań typowo technicznych również metody psychologiczne, takie jak wystandaryzowane kwestionariusze klaustrofobii i zaburzeń lękowych, powalające na wcześniejszą identyfikację pacjentów podwyższonego ryzyka, a także dążenie do stworzenia w czasie badania otoczenia bardziej przyjaznego pacjentowi.

Referencje dokumentu: Enders J, Zimmermann E, Rief M, Martus P, Klingebiel R, et al. (2011) Reduction of Claustrophobia with Short-Bore versus Open Magnetic Resonance Imaging: A Randomized Controlled Trial. PLoS ONE 6(8): e23494. doi:10.1371/journal.pone.0023494

Fot. Klasyczny skaner MRI z długą komorą prod. General Electric, źródło: National Institute of Mental Health | | |

Neuronauki

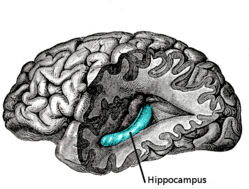

Dieta i hipokamp (15-03-2012) |  Prowadzono już wiele badań nad wpływem diety bogatej w nasycone kwasy tłuszczowe i cholesterol na poszczególne układy organizmu - ich wyniki dość jednoznacznie wykazywały długofalową szkodliwość takiego odżywiania, mechanizmy jednak prowadzące do uszkodzenia poszczególnych narządów nie zawsze są w pełni zrozumiałe. Linnea R Freeman i Ann-Charlotte E Granholm z Medical University of South Carolina postanowili sprawdzić co konkretnie pod wpływem bogatotłuszczowej diety dzieje się z hipokampem, jedną ze struktur układu limbicznego odpowiedzialną m.in. za pamięć i procesy uczenia się. Prowadzono już wiele badań nad wpływem diety bogatej w nasycone kwasy tłuszczowe i cholesterol na poszczególne układy organizmu - ich wyniki dość jednoznacznie wykazywały długofalową szkodliwość takiego odżywiania, mechanizmy jednak prowadzące do uszkodzenia poszczególnych narządów nie zawsze są w pełni zrozumiałe. Linnea R Freeman i Ann-Charlotte E Granholm z Medical University of South Carolina postanowili sprawdzić co konkretnie pod wpływem bogatotłuszczowej diety dzieje się z hipokampem, jedną ze struktur układu limbicznego odpowiedzialną m.in. za pamięć i procesy uczenia się.

Już wcześniejsze prace sugerowały zaburzenia funkcji hipokampa związane z bogatotłuszczową dietą, wiadomo też, że obszar ten jest szczególnie wrażliwy na zmiany niedokrwienne. Pojawiające się sugestie wiążące zaburzenia pamięci towarzyszące niektórym schorzeniom neurodegeneracyjnym z hipokampem właśnie i z uszkodzeniami tzw. bariery krew-mózg (BBB, blood-brain barrier) skłoniły naukowców do skupienia się na tej właśnie strukturze. Bariera krew-mózg to naturalna przegroda pomiędzy środowiskiem wewnątrz naczyń krwionośnych a tkanką nerwową wymuszająca selekcję transportowanych do mózgu substancji. Budują ją komórki śródbłonka naczyń włosowatych "sklejone" rozmaitymi białkami wchodzącymi w skład tzw. połączeń ścisłych (tight junctions) - m.in. okludyną i klaudyną oraz warstwa wypustek astrocytów (podtyp komórek glejowych budujących zrąb układu nerwowego). Już wcześniejsze prace sugerowały zaburzenia funkcji hipokampa związane z bogatotłuszczową dietą, wiadomo też, że obszar ten jest szczególnie wrażliwy na zmiany niedokrwienne. Pojawiające się sugestie wiążące zaburzenia pamięci towarzyszące niektórym schorzeniom neurodegeneracyjnym z hipokampem właśnie i z uszkodzeniami tzw. bariery krew-mózg (BBB, blood-brain barrier) skłoniły naukowców do skupienia się na tej właśnie strukturze. Bariera krew-mózg to naturalna przegroda pomiędzy środowiskiem wewnątrz naczyń krwionośnych a tkanką nerwową wymuszająca selekcję transportowanych do mózgu substancji. Budują ją komórki śródbłonka naczyń włosowatych "sklejone" rozmaitymi białkami wchodzącymi w skład tzw. połączeń ścisłych (tight junctions) - m.in. okludyną i klaudyną oraz warstwa wypustek astrocytów (podtyp komórek glejowych budujących zrąb układu nerwowego).

Badanie przeprowadzono na szczurach karmionych przez pół roku (od 6 miesiąca życia) specjalną karmą wzbogaconą w cholesterol (2%) i uwodorniony olej kokosowy (10%). Z zabitych zwierząt pobierano mózgi celem oceny morfologicznej naczyń i samego hipokampa. Badania immunofluorescencyjne wykazały znaczące w stosunku do szczurów z grupy kontrolnej obniżenie gęstości niektórych markerów bariery krew-mózg oraz niespodziewane zmiany w lokalizacji części białek budujących uszczelniające ją połączenia komórkowe - ekspresja okludyny była znacząco niższa w ścianach naczyń, jednak jednocześnie zauważono jej znacznie większą ilość w pewnych komórkach nerwowych hipokampa - naukowcy doszukują się w tym zjawisku prób poronnej kompensacji niedoborów tego białka w badanym obszarze. Zaobserwowano także zwiększoną w porównaniu z kontrolą liczbę komórek mikrogleju (mózgowe komórki żerne odpowiadające za uprzątanie obszarów uszkodzonych i lokalną odpowiedź immunologiczną) w hipokampach zwierząt poddanych bogatotłuszczowej diecie, przy czym komórki te wykazywały tendencję do skupiania się wokół naczyń krwionośnych, co można interpretować jako odpowiedź zapalną na obserwowane zmiany naczyniowe.

Zmiany diety u szczurów prowadziły nie tylko - co było łatwo przewidywalne - do nadwagi i podwyższonego poziomu cholesterolu we krwi, ale też do bezpośrednich zmian w integralności bariery krew-mózg na obszarze hipokampa i odpowiedzi zapalnej w tym obszarze mózgowia. To dość niewielkie badanie, jednak naświetlenie potencjalnej roli diety w powstawaniu uszkodzeń BBB jest kolejnym elementem poszerzającym naszą wiedzę o mechanizmach i patogenezie zaburzeń neurodegeneracyjnych, tym istotniejszym, że dieta akurat należy do stosunkowo łatwo modyfikowalnych czynników ryzyka. Zmiany diety u szczurów prowadziły nie tylko - co było łatwo przewidywalne - do nadwagi i podwyższonego poziomu cholesterolu we krwi, ale też do bezpośrednich zmian w integralności bariery krew-mózg na obszarze hipokampa i odpowiedzi zapalnej w tym obszarze mózgowia. To dość niewielkie badanie, jednak naświetlenie potencjalnej roli diety w powstawaniu uszkodzeń BBB jest kolejnym elementem poszerzającym naszą wiedzę o mechanizmach i patogenezie zaburzeń neurodegeneracyjnych, tym istotniejszym, że dieta akurat należy do stosunkowo łatwo modyfikowalnych czynników ryzyka.

Oryginalny artykuł: Linnea R Freeman and Ann-Charlotte E Granholm, Vascular changes in rat hippocampus following a high saturated fat and cholesterol diet, Journal of Cerebral Blood Flow & Metabolism (2011), 1-11. Abstrakt | | |

Technika

Innowacyjny sprzęt medyczny - niższe koszty i zużycie energii (14-03-2012) | Finansowani ze środków unijnych naukowcy wprowadzają innowacje, a sektor ochrony zdrowia ma być najnowszym beneficjentem ich prac. Naukowcy z projektu DESYRE (Niezawodność systemu na żądanie) opracowują system, który jest niezawodny, bazując jednak na zawodnych komponentach. Projekt DESYRE uzyskał dofinansowanie na kwotę 2,8 mln EUR z tematu "Technologie informacyjne i komunikacyjne" (TIC) Siódmego Programu Ramowego (7PR).

Przemawiając do uczestników niedawnej konferencji DATE 2012 w Dreźnie, Niemcy, kierownik projektu DESYRE - Ioannis Sourdis z Wydziału Inżynierii Komputerowej Politechniki Chalmers w Szwecji - powiedział, że sprzęt wykorzystywany obecnie przez świat medyczny, taki jak rozruszniki serca czy inne wszczepiane urządzenia medyczne, opiera się na trzech decydujących elementach: niezawodność, miniaturyzacja i trwałość. Tutaj właśnie do akcji wkracza konsorcjum DESYRE.

Eksperci oceniają, że wskaźniki wadliwości będą wzrastać wraz z rozwojem technologii. Zespół DESYRE pracuje nad nowymi technikami projektowania przyszłych "systemów SoC", aby podnieść poziom niezawodności, obniżając jednocześnie koszty związane z energią i wydajnością, które są powiązane z odpornością na błędy.

"Koncentrujemy się na projektowaniu przyszłych, wysoce niezawodnych systemów SoC, które zużywają znacznie mniej energii niż inne proponowane systemy wysokiej niezawodności" - wyjaśnia profesor Sourdis. "To podejście umożliwia projektowanie urządzeń łączących wysoką niezawodność z małymi bateriami i trwałością na miarę obecnych czasów. Idealnie nadają się do ważnych dla bezpieczeństwa zastosowań, takich jak wszczepialne urządzenia medyczne, na przykład rozruszniki serca czy urządzenia do głębokiej stymulacji mózgu, wykorzystywane w leczeniu choroby Parkinsona.

Większość prac badawczych poświęconych niezawodnym systemom zwykle koncentruje się na mechanizmach odpornych na błędy, które wykorzystują różne schematy nadmiarowości. W tym przypadku wrażliwe podsystemy są postrzegane jako "odporne na błędy". W celu oszacowania błędów w podsystemie potrzeba więcej energii, co z kolei obniża wydajność chipów. W ostatecznym rozrachunku przekłada się to na stratę czasu i energii.

Partnerzy projektu DESYRE dzielą system SoC na dwa odrębne obszary. Pierwszy jest wyjątkowo odporny na błędy, podczas gdy drugi zawiera komponenty przetwarzające, podatne na błędy. Naukowcy twierdzą, że rdzenie z obszaru podatnego na błędy są zamienne i zadanie wykonywane przez jeden rdzeń może być przeniesione na dowolny, inny rdzeń w przypadku stwierdzenia wadliwego działania. Tymczasem wolna od błędów część chipa obserwuje funkcjonowanie części podatnej na błędy, przeprowadzając "kontrole kondycji" rdzeni przetwarzających. Mają one także na celu zapewnienie bezbłędnego wykonywania wyznaczonego pod-zadania przez każdy z rdzeni.

"Nielogicznym może wydawać się projektowanie wysoce niezawodnego systemu SoC na bazie komponentów, które mogą zawieść, jednak na tym właśnie zasadza się nasza propozycja" - mówi Gerard Rauwerda, główny technolog Recore Systems B.V. z Holandii, jeden z partnerów przemysłowych DESYRE. "Zaleta podejścia DESYRE polega na tym, że system nadal wykonuje swoje zadanie w sposób niezawodny, nawet jeżeli jeden z rdzeni zadziała wadliwie, wydłużając trwałość chipa."

To innowacyjne, odporne na błędy urządzenie, pomoże, zdaniem zespołu, obniżyć zużycie energii o co najmniej 10 do 20% i zmniejszyć straty wydajności.

"Osoby potrzebujące wszczepialnych urządzeń medycznych również na tym skorzystają, gdyż przekłada się to na wydłużenie żywotności baterii i opóźnia wymianę urządzenia bez jakiegokolwiek uszczerbku dla jego niezawodności" - zauważa profesor Sourdis.

W skład konsorcjum DESYRE weszli eksperci z Grecji, Holandii, Szwajcarii, Wlk. Brytanii i Włoch.

© Unia Europejska, 1994-2012

Źródło: CORDIS

Referencje dokumentu: Na podstawie informacji uzyskanych z DESYRE | | |

Biologia

Pola magnetyczne i oscylacje pomagają mrówkom w nawigacji (14-03-2012) | Żyjące w surowym, pustynnym środowisku mrówki nie mogą polegać na punktach orientacyjnych w odnajdywaniu drogi, a mimo to nigdy się nie gubią. Naukowcy z Niemiec odkryli, że prócz liczenia kroków, te niesamowite stworzenia wykorzystują również oscylacje i pola magnetyczne, by bezpiecznie wrócić do domu po wyprawie w poszukiwaniu pożywienia.

Wcześniejsze badania pokazały, że mrówki stosują integrację ścieżki - to jest wykorzystują wskazówki do śledzenia odległości i kierunku, by oszacować swoje położenie geograficzne - w celu odnalezienia drogi do domu. Naukowcy pracujący w Instytucie Ekologii Chemicznej im. Maxa Plancka w Jenie, Niemcy, wykazali teraz, że mrówki pustynne mogą również posiłkować się magnetycznymi i oscylacyjnymi punktami orientacyjnymi podczas powrotu do gniazda. Wyniki badań zostały opublikowane w czasopiśmie PLoS ONE.

Podczas gdy integracja ścieżki jest, według europejskich naukowców, "fascynującym mechanizmem, który mrówki wykorzystują do orientacji" i "ważnym sposobem na przetrwanie w surowym środowisku pustynnym", to jednak metoda ta jest "podatna na błędy". Stąd dodatkowe korzystanie z wzrokowych i węchowych punktów orientacyjnych jako istotnych wskazówek. W przypadku mrówek, odnalezienie właściwego gniazda jest kwestią życia lub śmierci, gdyż mogą zostać zabite lub przynajmniej zaatakowane, jeżeli wejdą przypadkowo do nieodpowiedniego gniazda. Zespół badawczy postanowił zatem przetestować mrówki pustynne pod kątem umiejętności wykorzystywania magnetyzmu i sygnałów oscylacyjnych pod nieobecność innych punktów orientacyjnych. "Byliśmy zaskoczeni, że faktycznie tak jest" - stwierdza doktorantka Cornelia Buehlmann, która przeprowadziła doświadczenie.

Aby sprawdzić, jakie znaczenie dla mrówek mają magnetyczne i oscylacyjne punkty orientacyjne, Buehlmann wraz z kolegami umieściła kanał w pobliżu wejścia do gniazda i wyszkoliła niektóre mrówki w odnajdywaniu przynęty. Kanał zawierał magnetyczny, oscylacyjny, wzrokowy lub węchowy punkt orientacyjny, definiujący gniazdo. Naukowcy porównali następnie zachowanie tych mrówek z grupą kontrolą, która została przeszkolona w wyszukiwaniu przynęty, ale której kanał nie zawierał punktów orientacyjnych oraz z grupą "naturszczyków", która po raz pierwszy miała kontakt z punktem orientacyjnym w sytuacji testowej.

Naukowcy odkryli, że zarówno grupa kontrolna, jak i grupa "naturszczyków" zastosowała zgodnie z oczekiwaniami system integracji ścieżki w odnajdywaniu swoich gniazd, ignorując wszelkie zmiany w punktach orientacyjnych. Z kolei mrówki poddane szkoleniu, kiedy ich gniazda zostały skojarzone z punktem orientacyjnym, mijały je w przypadku zmiany punktu orientacyjnego. Szukały swojego gniazda w miejscu, gdzie pierwotnie znajdował się punkt orientacyjny i ignorowały informacje pochodzące z systemu integracji ścieżki.

Przeszkolone mrówki pustynne odnajdywały swoje gniazdo bez problemu, kiedy obok wejścia do gniazda zakopane było urządzenie oscylacyjne zasilane baterią. Jednakże, aby wykluczyć wszelki wpływ elektromagnetyczny urządzenia, naukowcy przeprowadzili doświadczenia z wykorzystaniem urządzenia oscylacyjnego bez kontaktu z gruntem, wówczas "mrówki zachowywały się jak te niewyszkolone" i "błąkały się bez celu".

Doświadczenia pokazały, że mrówki pustynne są "bardzo wrażliwe na sygnały oscylacyjne" - twierdzą naukowcy, ale przyznają, że nie jest jasne, którego zmysłu używają mrówki do orientowania się na podstawie sztucznie wytworzonego pola magnetycznego wokół gniazda.

"To nie oznacza, że mrówki posiadają jakiś organ czuciowy do wykrywania pól magnetycznych" - mówi pracujący w Instytucie dr Markus Knaden. "Ich zachowanie może być również wywoływane przez nieprawidłowe, neuronowe sygnały elektryczne wywoływane przez silne pole magnetyczne, zapamiętane przez mrówki." Jak by nie patrzeć - podsumowuje zespół - mrówki, które przystosowały się do wyjątkowo niesprzyjających siedlisk, wydają się być niezwykle elastyczne pod względem wykorzystywania wszystkich swoich zmysłów w nawigacji.

© Unia Europejska, 1994-2012

Źródło: CORDIS

Referencje dokumentu: Buehlmann, C., et al. (2012) 'Desert Ants Learn Vibration and Magnetic Landmarks', PLoS ONE 7, 3. DOI:10.1371/journal.pone.0033117 | | |

Neuronauki

Medialny szum wokół neuroenhancement (13-03-2012) |

Wprowadzenie

Wykorzystywanie leków stosowanych w leczeniu zaburzeń psychicznych, chorób i uszkodzeń mózgu w celu osiągnięcia poprawy niektórych funkcji psychicznych (nastrój, myślenie, uwaga, pamięć) u ludzi zdrowych wzbudza - między innymi za sprawą mediów - spore zainteresowanie opinii publicznej, a w związku z tym również bioetyków i samych neuronaukowców.

Zjawisko, które w języku angielskim zyskało miano neuroenhancement, czyli farmakologiczne wspomaganie czy też aktywizowanie pracy mózgu, ma wielu entuzjastów, którzy są skłonni utrzymywać, że tego rodzaju praktyki są szeroko rozpowszechnione, a ich popularność, zwłaszcza w krajach wysokorozwiniętych, stale wzrasta.

Zwolennicy wykorzystania leków psychotropowych (głównie psychostymulujących) i leków prokognitywnych (nootropowych) do usprawniania pracy mózgu u ludzi zdrowych podkreślają zazwyczaj korzyści związane ze stosowaniem tych środków.

Tymczasem nadal brak rzetelnych dowodów naukowych zarówno na to, że farmakologiczne aktywizowanie mózgu u ludzi zdrowych przynosi rzeczywiste korzyści (przy uwzględnieniu ryzyka ewentualnych skutków ubocznych), jak i na to, że jest to zjawisko tak szeroko rozpowszechnione, jak się to niekiedy utrzymuje. W związku z tym należy przypuszczać, że na kształtowanie bezkrytycznych oczekiwań społecznych wobec neuroenhancement istotny wpływ może mieć sposób, w jaki kwestia farmakologicznego wspomagania mózgu przedstawiana jest w popularnych mediach.

Tym właśnie zagadnieniem zajęło się pięcioro naukowców z Uniwersytetu Queensland (Australia). Wyniki ich badań zostały zaprezentowane ma łamach PLoS ONE w dniu 30 października 2011.

Jak zauważają autorzy badań, wywieranie wpływu przez media na społeczny odbiór danej dziedziny nauki nie jest problemem nowym. Współcześnie intensywny szum medialny, kształtujący spolaryzowane (przychylne bądź nieprzychylne) społeczne postawy i oczekiwania, otacza między innymi różne dziedziny badań genetycznych. Jeśli chodzi o neuronauki, to sporym zainteresowaniem medialnym cieszą się na przykład metody neuroobrazowania, metoda głębokiej stymulacji mózgu (DBS) czy problematyka farmakologicznego leczenia zespołu nadpobudliwości psychoruchowej z deficytem uwagi (ADHD).

Co warto zaznaczyć, szum medialny generowany jest niejednokrotnie przy udziale samego środowiska naukowego, które często nieadekwatnie - zbyt optymistyczne lub wręcz entuzjastycznie - rysuje przed odbiorcami świetlane perspektywy szybkiego zastosowania wyników badań w praktyce, wyolbrzymiając korzyści, a nie doceniając kosztów i ewentualnego ryzyka. Za wypaczony obraz możliwości neuronauk bywają więc odpowiedzialne nie tylko media.

"Przyczyną przesadnych reakcji mediów mogą być sami naukowcy - zauważają autorzy artykułu. - Swoimi badaniami na temat tego, w jaki sposób media przedstawiają badania neuronaukowe nad ADHD, Francois Gonon wraz ze współpracownikami zwrócili uwagę, że media często trafnie przekazują nadmierne oczekiwania naukowców co do możliwości wykorzystania wstępnych wyników badań dla celów terapeutycznych, a sami naukowcy są skłonni wyciągać wnioski idące o wiele dalej, niż rzeczywiście pozwalają uzyskane wyniki. Ponieważ mylące relacje mediów mogą niekorzystnie wpływać na przebieg rzetelnej debaty publicznej, bardzo ważną kwestią jest zrozumienie, w jaki sposób media przedstawiają badania i innowacje w neuronaukach".

Wśród naukowców nie brakuje osób, które nawet na łamach prestiżowych wydawnictw nie wahają się przed przytaczaniem nierzetelnych informacji o domniemanych dobrodziejstwach neuroenhacement i powszechności jego stosowania. Taki stan rzeczy sprzyja utrwalaniu opinii, że niektóre leki (modafinil, metylfenidat, donepezil czy dekstroamfetamina), stosowane w leczeniu ADHD, narkolepsji czy w przebiegu choroby Alzheimera to wręcz "sterydy dla mózgu" czy "bystre pigułki", "szeroko używane przez studentów", "o których dobrodziejstwach należy starać się przekonać społeczeństwo" itp. Nie brakuje wprawdzie tych, którzy podchodzą do sprawy z większym sceptycyzmem, zwracając uwagę między innymi na ryzyko uzależnienia i realne w przypadku większości wspomnianych substancji niebezpieczeństwo wystąpienia różnych skutków ubocznych, ale ich krytyczny głos, również za sprawą mediów, zdaje się mniej słyszalny.

Jaki jest stan faktyczny? W jaki sposób media odnoszą się do zjawiska neuroenhancement? Czy rzeczywiście nie tylko przesadnie podkreślają korzyści wynikające z farmakologicznego aktywizowania mózgu, ale również znacznie wyolbrzymiają skalę jego popularności?

Przebieg badań

W celu odpowiedzi na tak postawione pytania, naukowcy, wykorzystując specjalnie dobrane słowa kluczowe, przeszukali artykuły prasowe na temat neuroenhancement, jakie ukazały się w języku angielskim między 1 stycznia 2008 a 31 grudnia 2010 i zostały uwzględnione w bazie danych systemu wyszukiwawczego Factivia.

Z wyszukanych w ten sposób artykułów wybrano 142, które bezpośrednio traktowały o farmakologicznym aktywizowaniu mózgu, rozumianym jako wykorzystywanie leków psychostymulujących i prokognitywnych w celu osiągnięcia poprawy funkcji poznawczych u ludzi zdrowych. Wykluczono natomiast artykuły, które odnosiły się do nieprawidłowego używania leków niezwiązanego z neuroenhancement; wykorzystywania stymulantów do celów medycznych (np. w leczeniu ADHD), w sporcie i chirurgii plastycznej; wykorzystywania w celu stymulacji mózgu środków tzw. medycyny naturalnej; notatki prasowe o długości do 50 słów, recenzje książek i przedruki artykułów już raz opublikowanych (jeśli natomiast artykuł został opublikowany w dwóch formach - dłuższej i skróconej, traktowano je jak dwa niezależne utwory).

Następnie dokonano przeglądu artykułów pod kątem kilku kryteriów, takich jak (1) obecność w tekście twierdzeń dotyczących popularności neuroenhancement, (2) rodzaj źródła informacji na temat częstości używania neuroenhancement, na jakie powoływano się w tekście, (3) wspominanie o korzyściach związanych z używaniem farmakologicznego wspomagania mózgu i wreszcie (4) wzmiankowanie o ewentualnym ryzyku i skutkach ubocznych.

Wnioski

Osiemdziesiąt siedem procent artykułów (124 na 142) zawierało jakieś informacje na temat popularności neuroenhacement, z czego przeważająca większość (94%, 116 na 124 artykuły) informowała bądź o tym, że stosowanie farmakologicznego wspomagania mózgu jest powszechnym zjawiskiem, bądź że jego powszechność wzrasta. Pozostałe osiemnaście artykułów koncentrowało się na innej problematyce.

Tylko w 6 ze 142 artykułów wspominano, że stosowanie neuroenhancement jest dość rzadkie, z czego jedynie w dwóch wyrażano opinię, że jednoznaczna ocena powszechności jego stosowania nie jest możliwa ze względu na brak odpowiednich danych lub ograniczenia metodologiczne dostępnych badań.

W czterdziestu artykułach (33%) znalazło się co najmniej jedno stwierdzenie dotyczące popularności farmakologicznego wspomagania mózgu, które nie zostało poparte żadnym źródłem, w rodzaju: Coraz więcej zestresowanych studentów zażywa bystre tabletki, by znacznie poprawić swoje osiągnięcia na egzaminach, a w dziewiętnastu (15%) powoływano się co najmniej raz na źródła anegdotyczne, na przykład na wypowiedzi studentów. (Trudno przy tym powiedzieć, czy cytowane wypowiedzi były autentyczne, czy też ich źródłem była głównie fantazja redaktorów).

W osiemdziesięciu dwóch artykułach (66%) co najmniej raz powołano się na wyniki badań naukowych, ale z kolei w czterdziestu pięciu z nich nie wskazano na żadne konkretne źródło, to jest autora lub czasopismo, ale pisano ogólnie o "ekspertach", "naukowcach", "analizach", "badaniach" itp. W trzydziestu z owych czterdziestu pięciu artykułów powoływano się na wyniki bliżej nieokreślonych badań, a gdy już przytaczano dokładniej źródło, to wówczas okazywało się, że albo wyniki badań zostały nadmiernie uogólnione, albo wyciągano zbyt daleko idące wnioski na podstawie pojedynczych doniesień.

"W dziewięciu artykułach znalazło się stwierdzenie, że 16% studentów używa leków w celu farmakologicznego wspomagania mózgu, w stylu: Badania prowadzone w Stanach Zjednoczonych wskazują, że 16% studentów uczelni wyższych używa bystrych pigułek - zwracają uwagę naukowcy. - Wspomniane artykuły powołują się jednak najprawdopodobniej na badania autorstwa Babcock i Byrne, które często bywają omyłkowo przytaczane także w wielu najważniejszych pracach z dziedziny bioetyki jako dowód na szerokie rozpowszechnienie neuroenhancement. Jednak Babcock i Byrne tak naprawdę stwierdzili tylko, że 16,6% studentów w dosłownie jednej ze szkół artystycznych przyznało się do zażywania ritalinu dla celów rekreacyjnych przynajmniej raz w ciągu całego swojego dotychczasowego życia".

W piętnastu artykułach znalazły się stwierdzenia o jeszcze większej częstości stosowania neuroenhancement wśród studentów uczelni wyższych, sięgającej 25%. Ich autorzy powoływali się najprawdopodobniej na wyniki pewnych badań, przeprowadzonych w 119 amerykańskich koledżach, na których podstawie rzeczywiście stwierdzono, że w jednej ze szkół 25% uczniów przyznało się do co najmniej jednokrotnego zażywania stymulantów w ciągu ostatniego roku. Dla wszystkich 119 szkół średnia oscylowała wokół wartości 4-7% (dla co najmniej jednokrotnego zażycia w ciągu ostatniego roku lub całego dotychczasowego życia), o czym jednak wspomniano tylko w pięciu z piętnastu materiałów prasowych.

Z analizy artykułów wynika, że ich autorzy najczęściej przytaczali informacje z drugiej ręki, nie sięgając bezpośrednio do wyników badań, lecz powołując się na autorytet cytujących je w swoich pracach neuronaukowców i bioetyków. Bardzo często przytaczano również wyniki sondaży, prowadzonych przez strony internetowe (w tym Nature) lub inne media (w tym na przykład gazety studenckie), które jednak trudno uznać za reprezentatywne.

Dziewięćdziesiąt pięć procent artykułów wymieniało co najmniej jedną korzyść związaną ze stosowaniem farmakologicznego wspomagania mózgu, najczęściej poprawę pamięci, koncentracji uwagi, podniesienie poziomu aktywności, poprawę osiągnięć w nauce itp., nie podnosząc żadnych poważniejszych wątpliwości co do skuteczności leków. Jedynie w dwudziestu dwóch artykułach wyrażano pewne zastrzeżenia wobec skuteczności stosowania leków w celu wspomagania mózgu i tylko 58% artykułów wspominało o ryzyku związanym ze stosowaniem neuroenhancement.

"Wyniki naszych badań dają kilka powodów do obaw - podsumowują naukowcy. - Po pierwsze, mylące doniesienia medialne mogą skutkować tym, że działania publiczne podejmowane w tej dziedzinie będą źle poinformowane. Przekonanie o tym, że farmakologiczne wspomaganie mózgu jest powszechne, pozwala na skuteczna poprawę koncentracji lub uzyskiwanie lepszych ocen w szkole, może sprawić, że zostaną na tym polu niesłusznie podjęte kroki, które będą zachęcać do takich praktyk. W literaturze bioetycznej skutkuje to rekomendowaniem takich rozwiązań, jak: zalegalizowanie zażywania przez studentów psychostymulantów i leków prokognitywnych wydawanych bez recepty, zezwolenie koncernom farmaceutycznym na sprzedawanie tych leków ludziom zdrowym w celu farmakologicznego wspomagania mózgu, zapewnienie równego dostępu do tych leków wszystkim studentom, tak aby nikt nie był pozbawiony możliwości skorzystania z ich dobroczynnego działania. Kolejnym powodem do niepokoju jest możliwy wpływ mediów na zachowanie czytelników".

Duża część odpowiedzialności za jakość informacji naukowej, docierającej do opinii publicznej, spada zdaniem autorów także na samych neuronaukowców.

"Choć naukowcom zazwyczaj dość łatwo przychodzi obwinianie mediów o nieprawidłowe interpretowanie wyników badań, na nich samych również spoczywa etyczny obowiązek przekazywania informacji we właściwy sposób. Niedostatki w raportowaniu wyników badań, cytowaniu lub prezentacji danych przyczyniają się do tego, że wyniki badań mogą zostać niepoprawnie zinterpretowane przez innych naukowców, a także przez media. Pominięcie ważnej informacji, która ma decydujące znaczenie dla jakości uzyskanych wyników lub pozwala na przedstawienie ich w odpowiednim kontekście, może sprawić, że wnioski z badań zostaną poważnie zafałszowane, jak naszym zdaniem stało się w przypadku wykorzystywania leków stymulujących wydawanych na receptę w celu domniemanego wspomagania funkcji mózgu".

Referencje dokumentu: Partridge BJ, Bell SK, Lucke JC, Yeates S, Hall WD (2011) Smart Drugs ''As Common As Coffee'': Media Hype about Neuroenhancement. PLoS ONE 6(11): e28416. doi:10.1371/journal.pone.0028416

| | |

Genetyka

Gimnastyka zmienia DNA (13-03-2012) | Naukowcy z Danii, Irlandii i Szwecji odkryli, że gimnastyka może zmienić kwas dezoksyrybonukleinowy (DNA) w zaledwie kilka minut. Podczas gdy podstawowy kod genetyczny pozostaje niezmieniony, molekuły DNA w komórkach mięśni podlegają zmianom chemicznym i strukturalnym w bardzo szczególny sposób. Zyskują lub tracą znaczniki grup metylowych w konkretnych i znanych już sekwencjach DNA. Badania, zaprezentowane w czasopiśmie Cell Metabolism, zostały dofinansowane w formie grantów dla doświadczonych naukowców w ramach programu "Pomysły" Europejskiej Rady ds. Badań Naukowych z budżetu Siódmego Programu Ramowego (7PR).

Naukowcy, pracujący pod kierunkiem Karolinska Institutet ze Szwecji, poddali analizie sposób, w jaki gimnastyka wpływa na DNA osób zdrowych, które prowadzą jednak nieaktywny tryb życia. Zdaniem zespołu, tak zwane modyfikacje epigenetyczne DNA, w konkretnych lokalizacjach wydają się być kluczową korzyścią fizjologiczną zapewnianą przez ćwiczenia fizyczne.

"Nasze mięśnie są naprawdę plastyczne" - wyjaśnia profesor Juleen Zieratch z Wydziału Medycyny Molekularnej i Chirurgii Karolinska Institutet. "Często mawiamy 'Jesteś tym, co jesz'. Mięśnie natomiast dostosowują się do tego, co robisz. Jeżeli ich nie używasz, to tracisz je i jest to jeden z mechanizmów, który to umożliwia."